Kamerstuk

| Datum publicatie | Organisatie | Vergaderjaar | Dossier- en ondernummer |

|---|---|---|---|

| Tweede Kamer der Staten-Generaal | 2022-2023 | 26643 nr. 1056 |

Zoals vergunningen, bouwplannen en lokale regelgeving.

Adressen en contactpersonen van overheidsorganisaties.

U bent hier:

| Datum publicatie | Organisatie | Vergaderjaar | Dossier- en ondernummer |

|---|---|---|---|

| Tweede Kamer der Staten-Generaal | 2022-2023 | 26643 nr. 1056 |

Aan de Voorzitter van de Tweede Kamer der Staten-Generaal

Den Haag, 7 juli 2023

In de Werkagenda Waardengedreven Digitaliseren1 is uitgewerkt hoe dit kabinet de digitale transitie in goede banen wil leiden. We willen ervoor zorgen dat iedereen de mogelijkheden van digitale technologie kan benutten en dat publieke waarden en rechten daarin centraal staan. Iedereen moet kunnen meedoen in het digitale tijdperk, moet de digitale wereld kunnen vertrouwen en moet regie hebben op het digitale leven. Dat geldt bij uitstek voor nieuwe, zich snel verspreidende en potentieel disruptieve technologieën als (generatieve) AI en de toepassing van algoritmen. En dat in het bijzonder als het gaat om de toepassing daarvan door de overheid.

Deze brief gaat met name over algoritmen binnen de overheid.2 Toepassing van algoritmen biedt allerlei mogelijkheden om taken beter vorm te geven en uit te voeren. Maar er kleven ook risico’s aan en de inzet leidt met enige regelmaat tot maatschappelijke kritiek. De afgelopen tijd is hard gewerkt om die ontwikkeling de goede kant op te sturen. In Brussel krijgt de AI-verordening vorm, waarin Nederland veel van de eigen inzet in de Raadstekst heeft weten te verankeren. In afwachting van de besluitvorming daarover en de implementatie daarvan zetten we in eigen land stappen met onder meer een algoritme toezichthouder, een algoritmeregister en een implementatiekader voor de overheid.

Op 24 mei van dit jaar ontving u een brief met de stand van zaken van het toezicht in het digitale domein, in het bijzonder op AI en algoritmen. De laatste stand van zaken omtrent de AI-verordening heeft u ontvangen in de geannoteerde agenda voor de Telecomraad en hierover is gesproken in het commissiedebat over deze agenda.3 Nadat het Europees Parlement op 14 juni jl. heeft ingestemd met de EP-tekst van de AI-verordening, zijn de triloog onderhandelingen tussen de Raad, het Europees Parlement en de Europese Commissie van start gegaan. De laatste stand van zaken omtrent het Raad van Europaverdrag over AI heeft u op 2 juni jl. ontvangen in het verslag van het schriftelijke overleg hierover.4

In deze brief informeer ik uw Kamer over de voortgang van drie acties uit de Werkagenda Waardengedreven Digitaliseren (hierna: de Werkagenda), die bijdragen aan het juiste gebruik door de overheid van algoritmen. Dat zijn het Implementatiekader voor de Inzet van Algoritmen (IKA)5, de mogelijke verplichtstelling van het algoritmeregister vooruitlopend op de AI-verordening6 en het gebruik van de handreiking non-discriminatie. Daarbij ga ik in op een aantal moties en toezeggingen met betrekking tot dit onderwerp.7 In het najaar volgt een gehele actualisatie van de Werkagenda. Dit doe ik samen met een grote en diverse groep betrokkenen van binnen en buiten de overheid.

Daarnaast sta ik stil bij het visietraject op generatieve AI, dat mede is gestart naar aanleiding van de gewijzigde motie van de leden Dekker-Abdulaziz en Rajkowski.8 Hierbij is ook aandacht voor een tweetal toezeggingen die ik dit voorjaar in het kader van generatieve AI heb gedaan aan uw Kamer. Het gaat om een toezegging om u te informeren over de acties die de Italiaanse privacytoezichthouder en, afzonderlijk daarvan, Autoriteit Persoonsgegevens (AP) in Nederland hebben genomen met het oog op het large language model (LLM) ChatGPT en een toezegging om met een reactie te komen op de petitie «Control AI: Politiek, neem controle over AI».

Wanneer algoritmen of de complexere systemen als AI in een verkeerde context, op verkeerde wijze of met het verkeerde doel worden ingezet kan de impact groot zijn. Publieke waarden en fundamentele rechten zoals privacy, non-discriminatie, autonomie en menselijke waardigheid kunnen onder druk komen te staan, waardoor burgers in de knel komen. In het recente verleden zijn er diverse onderzoeken naar gedaan9 en daaruit leid ik af dat er belangrijke oorzaken zijn als er problemen zijn bij de inzet van algoritmen door de overheid, in het bijzonder:

1. Er worden tijdens het ontwikkelproces van algoritmen vooraf geen (duidelijke) criteria gesteld waaraan algoritmen moeten voldoen.

2. De controle en toetsing van ontwerp en implementatiekeuzes bij het ontwikkelen van algoritmen vinden te laat plaats.

3. De bestaande controlemechanismen functioneren onvoldoende, omdat niet altijd duidelijk is of algoritmen worden gebruikt en als ze worden gebruikt hoe ze functioneren.

Er is wet- en regelgeving die van toepassing is op de inzet van algoritmen. Denk aan de Algemene Verordening Gegevensbescherming (AVG) en de Algemene wet bestuursrecht (Awb). In de praktijk is echter gebleken dat in een ontwikkelfase de toets op wet- en regelgeving soms nog te laat plaatsvindt. Een deel van de verklaring is mogelijk dat AI of een algoritme nog te vaak wordt gezien als een technische oplossing voor een technisch probleem en dat keuzes die maatschappelijk van belang zijn in de ontwerp, ontwikkel- en implementatiefasen onvoldoende worden onderkend. Het Implementatiekader Algoritmen (IKA) moet bijdragen aan de oplossing hiervan (zie punt 2 verderop).

Een ander deel van de verklaring is dat de controle en toetsing worden bemoeilijkt, omdat gemaakte keuzes in het ontwerp en de implementatie van AI of algoritmen ondoorgrondelijk zijn. Hierdoor wordt het voeren van een maatschappelijk debat over de impact bemoeilijkt. Ook controlerende instanties zoals toezichthouders kunnen gemaakte keuzes mogelijk niet of onvoldoende toetsen, omdat niet duidelijk is welke keuzes met of door de technische oplossingen worden gemaakt. Het algoritmeregister moet bijdragen aan de oplossing hiervan (zie verder voor toelichting punt 4).

Het implementatiekader (IKA) heeft tot doel overheden te ondersteunen bij de verantwoorde inzet van algoritmen. Daartoe biedt het IKA een overzicht van de belangrijkste normen en maatregelen waaraan voldaan moet worden, en normen en maatregelen die niet verplicht zijn maar als handreiking dienen voor het waarborgen van publieke waarden. Het kader geeft ook inzicht in de functies, rollen en verantwoordelijkheden met betrekking tot controle en toezicht. Het kader draagt uiteindelijk bij aan een zorgvuldige en verantwoorde inzet van AI en/of algoritmen.

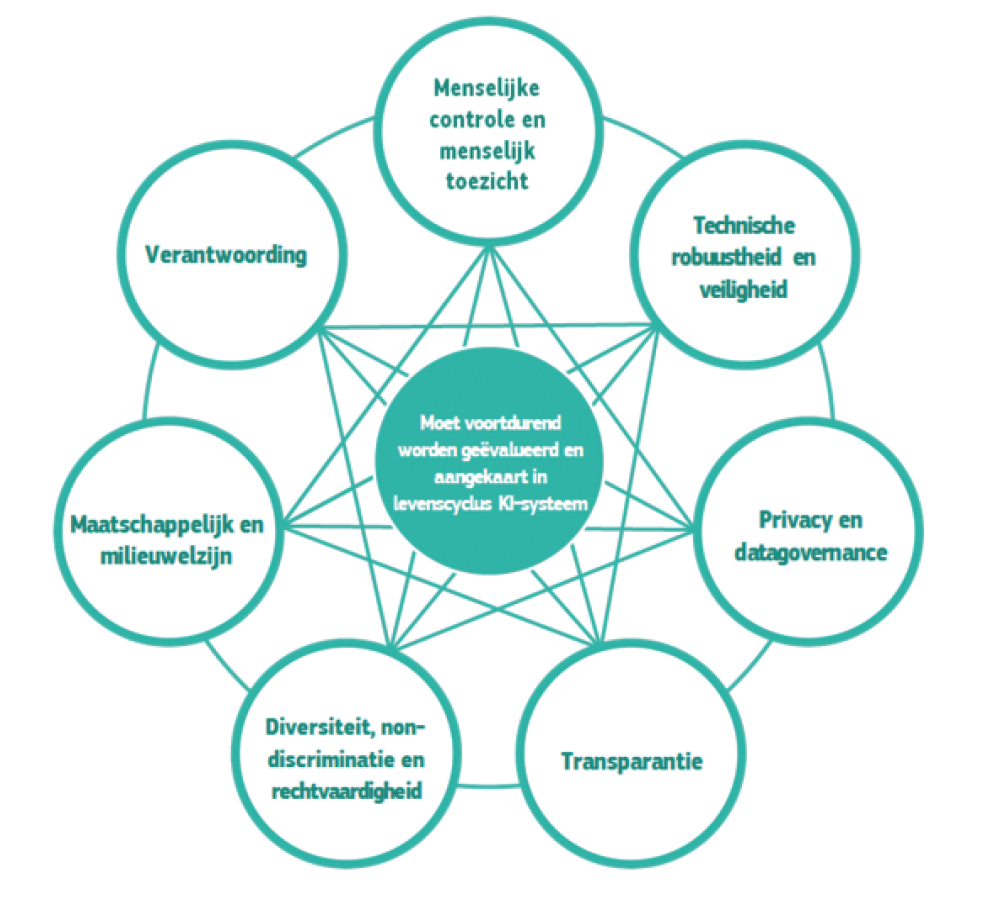

Het IKA is in lijn gebracht met de belangrijke onderwerpen uit de Ethische Richtsnoeren van de high-level expert group on artificial intelligence van de Europese Commissie10. Dit zijn gezaghebbende richtsnoeren waarvan ik vind dat die leidend moeten zijn bij de inzet van AI en/of algoritmen. Deze onderwerpen hebben ook mede de basis gevormd voor de AI-verordening:

1. Menselijke controle en menselijk toezicht

2. Technische robuustheid

3. Privacy en datagovernance

4. Transparantie

5. Diversiteit, non-discriminatie en rechtvaardigheid

6. Milieu en maatschappelijke waarden Verantwoording

Figuur 2 Onderlinge verhouding van de zeven onderwerpen (overgenomen uit de Ethische richtsnoeren)

Het IKA biedt aan de hand van deze 7 onderwerpen een overzicht van belangrijke onderliggende normen en maatregelen. Een deel van de normen en maatregelen die onder deze 7 onderwerpen zijn ondergebracht hebben een dwingend karakter en het niet naleven ervan kan juridische consequenties hebben. Daarnaast bevat het ook normen en maatregelen in de vorm van richtlijnen, aanbevelingen of best practices die niet juridisch bindend zijn, maar worden aanbevolen als goede ethische praktijken bij de inzet van algoritmen. Het IKA zorgt voor meer eenduidigheid door bestaande (toetsings) kaders en instrumenten te stroomlijnen, te prioriteren en op één plek toegankelijk te maken. Zo sluit het IKA aan op het normenkader dat de Auditdienst Rijk in 2022 heeft opgesteld11 en het toetsingskader algoritmen van de Algemene Rekenkamer.12

Het IKA richt zich primair op algoritmen die risico’s kunnen opleveren. Het IKA is een hulpmiddel voor overheidsorganisaties om hun algoritmen te toetsen. De risicobenadering van de AI-verordening zal hier leidend zijn. Daarbij is het uiteraard van belang om een inschatting te maken van de impact van het algoritme en mogelijk daarmee gepaard gaande risico’s. Er is een handreiking gemaakt die overheden helpt met het bepalen van een risico-inschatting.13

Het IKA is geen «checklist». Het nemen van de maatregelen in dit kader leidt veelal niet rechtstreeks tot het voldoen aan een verplichting en niet alle maatregelen in dit kader zijn verplicht. Gebruikers van dit IAK zullen dus nog altijd zelf moeten blijven nadenken en tot een eigen afweging komen. Het kader bevat ook de organisatie van het toezicht. Het maakt inzichtelijk hoe controle en toetsing van ontwerp en implementatiekeuzes plaatsvinden.

De doelgroep van het IKA is de gehele overheid (Rijk, provincies, gemeenten en waterschappen). Het IKA is er voor iedereen binnen de overheid, maar richt zich met name op de rollen die betrokken zijn bij de ontwikkeling, implementatie, toetsing en verantwoording van algoritmen. Het kader kan worden gebruikt om bestaande risico’s te inventariseren en kan als handvat dienen bij de ontwikkeling van nieuwe algoritmen.

Een mensenrechtentoets (zoals een Impact Assessment Mensenrechten Algoritme: IAMA) is in het IKA opgenomen als een geadviseerde maatregel die kan helpen om tijdig vast te stellen of wet- en regelgeving is nageleefd en of systemen in lijn zijn met publieke waarden. Uw Kamer heeft gevraagd om een mensenrechtentoets voorafgaand aan de ingebruikname van een AI of algoritmisch systeem te verplichten.14 Ik wil dit, zoals ik al eerder aan uw Kamer meldde15, in samenhang zien met de nieuwe verplichtingen die volgen uit de AI-verordening. Daarin is een verplichte risicoanalyse op mensenrechten opgenomen. De AI-verordening zal naar verwachting voorschrijven dat een hoog risico AI-systeem, dat op de markt wordt gebracht, voorzien moet zijn van een CE-markering. Met die verplichting wordt geborgd dat is gecontroleerd of het product in overeenstemming is met de regels die daarop van toepassing zijn voordat het op de markt wordt gebracht. Als deze verplichtingen inderdaad deel uitmaken van de AI-verordening zal het IKA worden bijgewerkt met deze inhoud. In afwachting van de AI-verordening heeft uw Kamer per motie van het lid Dekker-Abdulaziz16 gevraagd, alle nieuwe algoritmen met een hoog risico (op basis van meeste recente tekst in de AI-verordening) een mensenrechtentoets (IAMA) te laten ondergaan. Daar ga ik uitvoering aan geven.

Met het IKA geef ik deels uitvoering aan de motie van de leden Leijten en Ceder17 die verzoeken om een duidelijk waardenkader met betrekking tot de inzet, regulering en toepassing van digitale technologie door de overheid, waarbij duidelijk wordt aangegeven welke principes en waarden leidend zijn. In het IKA dat in deze brief is toegelicht, geef ik aan welke vragen en principes leidend zijn als het gaat om de inzet van AI en algoritmen door de overheid. Met uw Kamer deel ik de behoefte aan één duidelijk waardenkader dat toegepast kan worden bij digitalisering in het algemeen en in alle sectoren. Ik constateer daarbij dat er al meerdere waardenkaders zijn die tegelijkertijd gelden. Zo zijn de waarden die wij als maatschappij van fundamenteel belang achten, vastgelegd in de Grondwet. Hierbij valt te denken aan non-discriminatie, privacy en vrijheid van meningsuiting. De bescherming van deze waarden is uitgewerkt in wetgeving. De AVG ziet bijvoorbeeld toe op de bescherming van persoonsgegevens. Welke publieke waarden een rol spelen in concrete situaties is (mede) afhankelijk van de sector en het specifieke geval. Per sector zijn daarom waarden verder uitgewerkt.

Zo zijn in de Code Goed Digitaal Openbaar Bestuur 30 specifieke waarden voor de overheid uitgewerkt (denk aan burgerbetrokkenheid, inclusiviteit en transparantie). Tegelijkertijd heb ook ik de behoefte om de waardenkaders zoals deze Code in samenhang te beschouwen en te verbinden. Na de zomer organiseer ik daarom een expertsessie om dit soort bestaande waardenkaders die van toepassing zijn op digitale technologie (in zijn algemeenheid) in samenhang te beschouwen en zal waar nodig ook verder onderzoek doen. Op basis hiervan zal ik uw Kamer in de tweede helft van 2023 per brief informeren over hoe we bestaande waardenkaders meer kunnen verbinden.

Het IKA is een «levend» document. De eerste versie van dit kader is opgenomen als bijlage bij deze brief. Dit is conform de toezegging in de Werkagenda. Het betreft een eerste versie die dient als startpunt voor een gedegen proces waarin de experts en overheidsorganisaties waarvoor het IKA is bedoeld nadrukkelijk worden betrokken. De rest van dit jaar en volgend jaar wil ik gebruiken voor de doorontwikkeling van het IKA langs een aantal lijnen:

• Actualisatie

Het IKA zal worden geactualiseerd en aangepast op basis van suggesties voor verbeteringen, nieuwe normenkaders of wetgeving (b.v. AI-Verordening). Dit is een doorlopend proces.

• Uitbreiding

Het IKA zal in een volgende versie worden uitgebreid met best practices en hulpmiddelen op het gebied van inzet van algoritmen (bijvoorbeeld via bestaande of te ontwikkelen handreikingen) waarbij wordt gekeken naar bruikbaarheid en uitvoerbaarheid. Deze versie zal in het eerste kwartaal van 2024 af zijn.

• Organisatorische inbedding

Het IKA zal in de volgende fase van de doorontwikkeling inzicht geven in hoe de governance wordt ingericht, dus op welke wijze de normen, toetsingskaders en wetgeving op het gebied van algoritmen kunnen worden ingebed in de organisatie en hoe het (externe) toezicht zal worden georganiseerd. Deze fase zal in het vierde kwartaal van 2024 afgerond zijn.

In het eerste kwartaal 2024 zal ik u berichten over de voortgang.

Eind 2022 heeft het kabinet het algoritmeregister voor overheidsorganisaties gelanceerd. Hierin zijn de algoritmen opgenomen die de overheid ontwikkelt of gebruikt en die aanmerkelijke impact kunnen hebben op burgers. Er is een handreiking opgesteld om overheidsorganisaties te helpen bij de publicatie van algoritmen in het register. Uw Kamer heeft per motie van het lid Dassen c.s.18 gevraagd om de publicatie van dergelijke algoritmen van de overheid te verplichten en ook om u voor de zomer 2023 te informeren over de mogelijkheid van een verplicht algoritmeregister, vooruitlopend op de AI-verordening.19

Om antwoord te geven op deze vragen is het allereerst belangrijk om te weten hoe ik het verplicht stellen van het register zie in verhouding tot de verplichtingen in de toekomstige AI-verordening. Die betreffen onder meer transparantie-eisen aan hoog risico AI-systemen en hun aanbieders, maar ook de verplichting voor gebruikers om hun AI-systeem te registreren in een EU-databank.20

Voor algemeen gebruik zijn deze wellicht voldoende. We moeten de definitieve tekst nog afwachten, maar gezien de beperkte registratieverplichtingen die nu worden voorgesteld in de Raadstekst is de te registreren informatie voor AI-systemen waarschijnlijk niet voldoende om de noodzakelijke transparantie voor het gebruik door overheden, waar het in deze brief specifiek over gaat, te borgen. Dit gelet op de specifieke context van het gebruik van algoritmen door overheden, de risico’s die dit met zich brengt en het feit dat burgers afhankelijk zijn van de overheid. Dat maakt het zeer aannemelijk dat voor het gebruik van bepaalde algoritmen door overheden, ook wanneer het AI-systemen betreft, aanvullende registratieverplichtingen wenselijk zijn. Dit zal ik bezien als de definitieve verordening bekend is. Ook neem ik dit mee in de volgende fase van het IKA, die ik in het vierde kwartaal van dit jaar af wil ronden.

De bepalingen in de AI-verordening over de registratie in de EU-bank gaan uit van maximumharmonisatie. Achterliggend doel is om te voorkomen dat aanbieders van systemen in elk land met andere regels worden geconfronteerd. Door deze maximumharmonisatie is er geen of slechts beperkte ruimte om nationaal aanvullende regels te stellen voor aanbieders. De AI-verordening laat ruimte om nationaal extra registratieverplichtingen op te leggen aan gebruikers van systemen die binnen de reikwijdte van de verordening vallen. Uiteraard kunnen registratieverplichtingen worden opgelegd aan systemen die buiten de reikwijdte van de verordening vallen.

Ik vind het van belang om ook voor sommige simpelere systemen – die dus buiten de reikwijdte vallen – extra regels op te stellen voor het register omdat we in het verleden hebben gezien dat ook die bij inzet door de overheid kunnen leiden tot ongewenste effecten, zoals discriminatie. Wat er eventueel buiten die reikwijdte valt wil ik nog nader bezien en vaststellen nadat de definitieve tekst van de AI-verordening bekend is.

Veel van de toepassingen die in bijlage III van de AI-verordening als hoog-risico AI-systemen zijn geclassificeerd, zijn overheidssystemen. Omdat burgers in veel gevallen afhankelijk zijn van de overheid, is het logisch dat voor overheden op dit punt strengere normen gelden.

Ik wil in het register tenminste de hoog risico algoritmen opnemen. Ik spreek hier van «tenminste», want ik wil nog nader vast kunnen stellen of er voor overheidstoepassingen die niet direct hoog risico zijn, maar wel impactvol kunnen zijn, een verplichting moet komen om deze te publiceren in het algoritmeregister. Ook hier zal ik in het eerste kwartaal van 2024 op terugkomen.

Uw Kamer heeft mij gevraagd naar de mogelijkheid om registratie van AI en algoritmen van de overheid in het algoritmeregister verplicht te stellen, vooruitlopend op de AI-verordening. Laat ik vooropstellen dat ik het belang van een verplichte registratie met u deel. Hiervoor heb ik de relatie met de AI-verordening geschetst. Een wetsvoorstel met een nationale aanvullende registratieverplichting moet passen binnen de kaders die de AI-verordening biedt voor de Europese databank. De positie van de Raad en van het Europees Parlement daarover zijn bekend, maar we moeten nog wachten op de definitieve tekst van de verordening voordat duidelijk is wat onze nationale ruimte is. Vooruitlopend een wetsvoorstel in procedure brengen leidt niet tot tijdswinst ten opzichte van de inwerkingtreding van de AI-verordening, maar mogelijk wel tot regels die daar niet op aansluiten. Om te voorkomen dat de uitvoeringspraktijk met steeds andere verplichtingen wordt geconfronteerd, vind ik het belangrijk dat de nationale verplichting in samenhang met de AI-verordening wordt beschouwd.

De overheid moet het goede voorbeeld geven, ook zonder verplichting. Sinds de lancering van het register in december van vorig jaar is het aantal geregistreerde algoritmen slechts licht gestegen van 109 naar 123 (eind juni). Dat moet beter. We hebben afgesproken met alle ministeries, om vooruitlopend op de komst van het verplichte algoritmeregister (dat samenhangt met de AI-verordening), te beginnen met het registreren van overheidsalgoritmen. Dat betekent dat ieder ministerie nu aan het werk is. We hebben daarnaast afgesproken dat het algoritmeregister up-to-date is in 2025 en dat dan ten minste de hoog risico algoritmen geregistreerd zijn in het algoritmeregister. Mijn collegaministers van Economische Zaken en Klimaat (EZK) en Justitie en Veiligheid (JenV) hebben in het debat van 13 juni jongstleden ook uw Kamer desgevraagd laten weten bezig te zijn met de registratie van overheidsalgoritmen. Ook andere departementen hebben mij laten weten hard te werken om zoveel mogelijk algoritmen zo snel mogelijk in het register op te nemen. Dat vraagt tijd. Sommigen zijn al wat verder, anderen zijn nog iets minder ver. In een jaarlijkse voortgangsrapportage melden de departementen over hun voortgang.21 Door de CIO Rijk is aan de ministeries gevraagd om te komen tot een planning per departement. In de tweede helft van het jaar informeer ik u hier verder over.

Zoals toegezegd in de Voortgangsbrief publieke controle op algoritmen (7 oktober 2022)22 zou ik u, mede ter uitvoering van de moties van het lid Van Baarle c.s.,23 informeren over de strategische aanpak voor de verspreiding van de handreiking non-discriminatie by design, die tevens wordt opgenomen in het IKA.

De handreiking non-discriminatie by design maakt normen inzichtelijk die voortvloeien uit wet- en regelgeving op het gebied van non-discriminatie en die relevant zijn bij ontwerp en implementatiekeuzes van algoritmen en/of AI-systemen.24 Het helpt ontwikkelaars om de juiste vragen te stellen en om discriminatie door algoritmen of AI-systemen zoveel mogelijk te voorkomen.

De handreiking, gepubliceerd in 202125, is door adviesraden onder de aandacht gebracht26 en er zijn kruisverwijzingen gemaakt tussen instrumenten. Zo verwijzen het Impact Assessment Mensenrechten en Algoritmen (IAMA)27 en de Toolbox Ethisch Verantwoorde Innovatie28 beiden naar de handreiking. Tevens is de handreiking opgenomen in diverse onderwijscurricula29 en zijn er artikelen rondom de handreiking gepubliceerd op domein specifieke fora en communities.30

Uw lid van Baarle heeft bij motie verzocht om één jaar na de verspreiding van deze handreiking te onderzoeken in hoeverre de handreiking bekend is bij overheidsdiensten en lokale overheden en te onderzoeken in hoeverre de aanbevelingen worden geïmplementeerd.31 Ik heb dit via de CIO-Rijk laten onderzoeken onder alle departementen en uitvoeringsorganisaties. De Auditdienst Rijk (ADR) is gevraagd om aanvullend diepteonderzoek te doen aan de hand van een achttal interviews bij departementen en uitvoeringsorganisaties.

Uit de CIO-uitvraag is gebleken dat de handreiking bij een groot deel (73%) van de departementen bekend is. Van hen geeft ruim de helft aan dat ze ook kennisgenomen hebben van de inhoud. In totaal heeft 8% van de departementen de handreiking gedeeltelijk of eenmalig toegepast. De handreiking speelt een faciliterende rol voor het voeren van het juiste gesprek rond het borgen van non-discriminatie, of wordt (deels) verwerkt in een zelf ontwikkeld kader. Tot slot overweegt 7% de handreiking te gaan gebruiken.

Uit het ADR-onderzoek blijkt voorts dat de handreiking door de geïnterviewden als begrijpelijk en inzichtelijk wordt ervaren als het gaat om risico’s, normen en mogelijke maatregelen. Op het punt van taken en rolverdelingen is de handreiking niet duidelijk genoeg. Daarnaast is er ook behoefte aan één integraal kader of een routekaart, die meerdere normen en principes omvat en de verbinding maakt met normen en toetsingskaders van controlerende instanties. Organisaties willen graag meer informatie krijgen over welke criteria en weging kunnen helpen het risico op discriminatie bij het gebruik van een algoritme in te schatten. Een ander genoemd verbeterpunt is het vergroten van het bewustzijn over algoritmen en (data-)ethiek in organisaties. De handreiking zou in die zin nog meer gekoppeld kunnen worden aan de afweging van waarden en ethiek. Het rapport van de ADR treft u aan als bijlage bij deze brief.

Op basis van deze bevindingen en om uitvoering te geven aan de moties, zet ik in 2023 in op nader onderzoek, opleiding en communicatie om de handreiking verder onder de aandacht te brengen bij zowel private als publieke partijen. De aanpak bestaat uit vijf onderdelen:

a. Opnemen in het IKA

De normen die in de handreiking worden genomen en de maatregelen om risico's op bias en discriminatie te mitigeren, maken onderdeel uit van het IKA. Daarmee wordt tegemoetgekomen aan de behoefte aan één integraal kader. In de doorontwikkeling van het IKA zullen ook de verdeling van taken en verantwoordelijkheden uitgeschreven worden.

b. Opleiding en training

Er worden leeroplossingen ontwikkeld, denk hierbij aan een e-learning module, een fysieke workshop, of een learning game. De handreiking is voornamelijk geschreven vanuit een juridisch oogpunt, maar met name de beheersmaatregelen die worden voorgesteld dienen te worden toegepast in de organisatie, in de techniek en in programmeertalen. Belangrijk is, en dat onderstreepte de ADR evaluatie ook, dat daarbij een gemeenschappelijke taal ontstaat waarbij juridische uitgangspunten vertaald worden naar het werk wat bijvoorbeeld ontwikkelaars doen, of andersom. Betrokkenen leren elkaar beter begrijpen, waardoor de samenwerking wordt versterkt en rollen- en verantwoordelijkheden gedurende de levenscyclus van systemen beter opgepakt kunnen worden. De doelgroep zijn projectleiders, ontwikkelaars, data scientists en (juridische) experts. De eerste leeroplossing wordt dit najaar gepresenteerd. De ontwikkelde leeroplossing zal vervolgens worden aangeboden aan verschillende (Rijks) overheidsopleidingsinstituten en kennisinstellingen.32 Waar nodig ontwikkelen we samen met deze partijen voor hun doelgroep specifieke leermodules. De leergang is niet verplicht.

c. Communicatiecampagne

Om private partijen te bereiken en de handreiking binnen sectoren te verspreiden wordt een doel(groep)gerichte communicatiecampagne ontwikkeld. Daarmee geef ik invulling aan de motie van het lid Van Baarle c.s. die verzoekt om actief de kennis van de handreiking non-discriminatie by design te verspreiden onder private partijen die mogelijk aan afkomst gerelateerde persoonsgegevens verwerken.33 Het gaat om private partijen die in opdracht van de overheid AI en/of algoritmische systemen ontwikkelen.

d. Vergroten publieke kennis

Samen met maatschappelijke organisaties willen we de publieke kennis over de risico’s op vooringenomenheid en de uitlegbaarheid van algoritmische systemen vergroten. Dit doen we door ervaringen met biastoetsing (in publiek-private context), werkmethoden en best practices rondom (semi-) geautomatiseerde besluitvormingscasussen publiek toegankelijk te maken. Het bevorderen van gezamenlijke normuitleg in de toezichtspraktijk ten aanzien van algoritmen is één van de geformuleerde doelen van de algoritmetoezichthouder.34 Daarom worden dit jaar vijf expertsessies georganiseerd, waarbij experts, toezichthouders, wetenschappers en stakeholders met elkaar het gesprek aangaan over belangrijke normen, waaronder non-discriminatie en bias-toetsing. Bij dit onderdeel neem ik ook de motie mee van het lid Kathmann c.s. die verzoekt te onderzoeken in hoeverre de inzet van expertteams die op vertrouwelijke basis volledige inzage krijgen in een algoritme succesvol kan zijn in het bestrijden van discriminerende algoritmen.35 Ik zal hier in het eerste kwartaal van 2024 op terug komen. Het belang van een dergelijk aanpak werd benadrukt in een gesprek dat ik had met de heer Krijger van de Erasmus Universiteit en waarvan ik had toegezegd uw Kamer over de resultaten van het gesprek te informeren.36

Recent heb ik in Singapore gezien hoe de AI Verify Foundation, met steun van de overheid, werkt aan een wereldwijde gemeenschap om te komen tot AI die vertrouwd kan worden. Daarbij worden ook hulpmiddelen ontwikkeld om AI te kunnen valideren. Grote bedrijven hebben voor deze aanpak interesse getoond. Ik vind het belangrijk om ook in Nederland kennis en ervaring op te bouwen met validatie van AI en daarbij met internationale initiatieven samen te werken. Zo ondersteun ik in Nederland Algorithm Audit, een non-profitorganisatie die kennis over ethische algoritmen opbouwt en deelt en zich daarnaast buigt over concrete gebruikssituaties van algoritmische hulpmiddelen.

e. Stimuleren gebruik van IAMA’s

Een belangrijk onderdeel van de campagne is het stimuleren van het gebruik van mensenrechtentoetsen. De Kamer heeft mij via de motie van het lid Van Baarle gevraagd om gemeenten te selecteren om aan de slag te gaan met het gebruik van mensenrechtentoetsen zoals een Impact Assessment Mensenrechten en Algoritmen (IAMA) dat in opdracht van BZK is gemaakt.37 Ik heb een aantal gemeenten gevraagd om hier medewerking aan te verlenen. Daarbij krijgen ze ondersteuning vanuit de Universiteit Utrecht en het Rijks ICT Gilde aangeboden. Er is contact (geweest) met twaalf gemeenten en twee provincies. Er zijn nu acht trajecten daadwerkelijk opgestart en nog vier in afwachting. Het gaat om verschillende casussen, zoals het meten van geluidshinder (Zuid-Holland), meten van privacy in relatie tot inzet van drones (Provincie Den Bosch), camerabeelden die geweld kunnen herkennen (gemeente Den Bosch), wijkaanpak (gemeente Assen), fraude opsporing (gemeente Enschede), zorgplatform ten behoeve van kwaliteitsbevordering (gemeente Veenendaal), Havenregistratie en Wet Maatschappelijke Ondersteuning (gemeente Den Haag). Twee gemeenten doen niet mee omdat ze geen casus voor zichzelf zagen. De bekendheid met het IAMA groeit bij gemeenten, maar om meer gemeenten over de streep te trekken is meer communicatie nodig. Het belang van het IAMA zal ik meenemen in mijn communicatiecampagne.

Niet alleen gemeenten worden gestimuleerd de IAMA te gebruiken. Bij de Onderwijsinspectie (precieze algoritme staat nog niet vast), bij de Marechaussee (grensbewaking), Logius (fraudedetectie), de Belastingdienst (precieze algoritme staat nog niet vast) worden IAMA’s gedaan.

Het IAMA zal verder onderdeel uitmaken van het IKA. Een IAMA wordt verplicht voor alle nieuw te ontwikkelen risico algoritmen, zoals ik net aangaf, en ik zal ook stimuleren dat de IAMA wordt ingezet waar nodig en wenselijk.

In de verzamelbrief publieke controle op algoritmen38 heb ik toegezegd om terug te komen op het tweede deel van de motie van het lid Koekoek die vraagt naar mogelijkheden om de implementatie of het gebruik van discriminerende algoritmen en IT-systemen stop te zetten wanneer niet kan worden vastgesteld dat zij geen discriminerende werking hebben.39 Het is belangrijk om tijdig te controleren en te toetsen of er geen bias en discriminatie is Het verbod op discriminatie en een aantal van de te nemen maatregelen ter voorkoming van discriminatie zijn onderdeel van het IKA. De hoog risicosystemen in de AI-verordening moeten gecontroleerd worden op bias en discriminatie, voordat ze op de markt komen, maar ook gemonitord worden gedurende het gebruik.40

De aangehouden motie van het lid Van Baarle verzoekt de regering om een protocol op te stellen waarin wordt vastgesteld hoe er gehandeld wordt bij geconstateerde bevooroordeeldheid of discriminatie in overheidshandelen, waaronder het informeren van betrokkenen of gedupeerden, het extern onderzoeken van de gevolgen, mogelijke sanctionering van verantwoordelijken en waarborgen voor de toekomst.41In het Commissiedebat over de inzet van algoritmen en data-ethiek van 15 februari jl. heb ik aangegeven het belangrijk te vinden dat er zo’n protocol komt. Er zijn reeds belangrijke regels waar algoritmen aan moeten voldoen als het gaat om discriminatie. En met de AI-verordening en het IKA zorgen we ervoor dat controle en toetsing eerder en beter plaatsvinden.

Mocht het onverhoopt toch misgaan dan moet er een werkwijze zijn met daarin de stappen die je in een dergelijk geval zou moeten zetten. Een belangrijke eerste stap zou wat mij betreft zijn dat mensen, wiens gegevens onrechtmatig zijn gebruikt en die hier mogelijk gevolgen van ondervinden, geïnformeerd worden. Ik verwacht na de zomer te starten met de interdepartementale afstemming en de technisch-organisatorische consequenties van de inbedding van het protocol, zodat alle overheden ermee aan de slag kunnen. Ik verwacht de Kamer hierover begin 2024 te kunnen infomeren. Ook dit protocol wil ik op gaan nemen in het IKA. Hierover informeer ik u graag verder over in het eerste kwartaal van 2024.

Hieronder ga ik nader in op de stappen die worden genomen om dit jaar tot een (kabinets)visie op generatieve AI te komen.42 Dit visietraject is mede gestart op basis van de gewijzigde motie van de leden Dekker-Abdulaziz en Rajkowski die tijdens het tweeminutendebat AI van 28 maart jl. is ingediend (Handelingen II 2022/23, nr. 66, item 31).43

Vervolgens wordt er aandacht besteed aan de acties van de Italiaanse privacytoezichthouder en Autoriteit Persoonsgegevens (AP) met het oog op het large language model (LLM) ChatGPT. Dit heb ik uw Kamer op 17 mei jl. toegezegd in het debat over de bescherming van online gegevens (Handelingen II 2022/23, nr. 82, item 11).

Tot slot geef ik uw Kamer mijn reactie op de petitie «Control AI: Politiek, neem controle over AI» die in juni 2023 is gepubliceerd.44 Dit heb ik uw Kamer tijdens het Wetgevingsoverleg (WGO) digitalisering van 13 juni jl. toegezegd.

a. Aanpak visietraject generatieve AI

Samen met andere departementen, waaronder het Ministerie van Economische Zaken en Klimaat (EZK), het Ministerie van Justitie en Veiligheid (JenV) en het Ministerie van Onderwijs, Cultuur en Wetenschap (OCW), werk ik hard aan een gedragen kabinetsvisie die voor het einde van het jaar met uw Kamer zal worden gedeeld.

In dit kader zijn en worden er de (komende) maanden verschillende sessies – in verschillende sectoren zoals onderwijs, openbaar bestuur, media en zorg – met experts, professionals en burgers georganiseerd. Deze input zal worden meegenomen in de kabinetsvisie. Ook worden de andere overheden, maatschappelijke organisaties en private partijen gevraagd om mee te denken via een klankbordgroep.

In de visie zal er aandacht zijn voor de aard van de technologie, de kansen en risico's voor de samenleving en verschillende sectoren, het bestaande juridische kader, de aankomende wet- en regelgeving (zoals de Europese AI-verordening) en het handelingsperspectief, inclusief de daarbij (mogelijk) horende acties.

b. Acties AP en Europese toezichthouders in het kader van LLM’s

Laat ik vooropstellen dat ik het belangrijk vind dat toezichthouders op het gebied van LLM’s in Europees verband samen optrekken. Ik heb daarom in juni met de AP gesproken over het belang van (gezamenlijk) toezicht op de naleving van de Algemene verordening gegevensbescherming (AVG) bij het gebruik van generatieve AI.

Eind maart 2023 heeft de Italiaanse toezichthouder Garante per la Protezione dei Dati Personali (GPDP) na het instellen van een vooronderzoek het gebruik van ChatGPT in Italië tijdelijk verboden. Op 28 april jl. werd ChatGPT weer beschikbaar gesteld in Italië nadat OpenAI – de Amerikaanse ontwikkelaar van ChatGPT – verschillende aanpassingen heeft gedaan om tegemoet te komen aan bezwaren van de GPDP. Zo is gebruikers onder meer de mogelijkheid geboden hun privacy-instellingen te wijzigen en kan ervoor worden gekozen om het bewaren van chatgesprekken uit te zetten zodat deze gegevens niet gebruikt worden voor het trainen van het algoritme (een opt-out mogelijkheid) en is het mogelijk om onjuiste informatie te laten wissen. Daarnaast heeft OpenAI voor (nieuwe) gebruikers haar privacybeleid toegankelijk gemaakt vanaf de registratiepagina en wordt er meer informatie gegeven over de verwerking van persoonsgegevens van gebruikers en de maatregelen die zij zelf kunnen treffen. Ook worden er maatregelen met betrekking tot leeftijdsverificatie getroffen.

De GPDP schrijft dat zij ondanks de verbetermaatregelen zal doorgaan met het vooronderzoek dat is gestart naar OpenAI onder de paraplu van een Taskforce ChatGPT die is opgericht binnen het Europees Comité voor gegevensbescherming (EDPB). De Nederlandse Autoriteit Persoonsgegevens (AP) maakt, net als alle andere privacytoezichthouders in de EU, ook onderdeel uit van deze taskforce.

De taskforce wil de samenwerking en informatie-uitwisseling over mogelijke handhavingsmaatregelen bevorderen. Dit is van groot belang omdat generatieve AI, zoals het large language model kunstmatige intelligentie (AI) systeem ChatGPT, zich niet aan landsgrenzen houdt. Dat vergt gezamenlijke actie van de privacytoezichthouders binnen de EU.

Op 7 juni jl. heeft de AP aangekondigd opheldering te vragen aan OpenAI over de omgang met persoonsgegevens.45 Belangrijke aandachtspunten zijn dat de AP van OpenAI vraagt om meer informatie te verschaffen over de manier waarom OpenAI persoonsgegevens van internet verzamelt en hoe het bedrijf omgaat om de persoonsgegevens die gebruikt worden bij de training van het systeem achter ChatGPT. Hierbij kan bijvoorbeeld gedacht worden aan de zogeheten «prompts» – de teksten die een gebruiker invoert in ChatGPT – net als de persoonsgegevens die worden verzameld door OpenAI om haar model te trainen. Deze gegevens kunnen zeer persoonlijk en gevoelig zijn.

Ook wenst de AP meer duidelijkheid te krijgen over de output die ChatGPT (in sommige gevallen) genereert. Er bestaan risico’s dat de output onjuiste, verouderde of aanstootgevende informatie over personen bevat en deze gegevens kunnen een eigen leven gaan leiden. De AP stelt ook vragen over de manier waarop gebruikers hun eigen gegevens kunnen rectificeren of verwijderen.

c. Reactie op petitie «Control AI»

Dan uw vraag naar mijn reactie op de petitie van 12 juni jl. Ik erken de zorgen van de initiatiefnemers: de impact van AI op onze samenleving raakt een breed scala aan sectoren, nu en in de toekomst. De initiatiefnemers roepen de Nederlandse politiek op om de controle te nemen. Dat doen we ook.

In nationaal, Europees en internationaal verband dragen we onze inzet op mensgerichte AI uit en doen we veel om de kansen van AI te benutten en de risico’s van AI tegen te gaan.

Nederland speelt een actieve rol in de onderhandelingen over zowel de AI-verordening van de EU als het AI-verdrag van de Raad van Europa. Dat gebeurt veel achter de schermen, maar is daarom niet minder invloedrijk.

De Europese wet stelt specifieke eisen aan de ontwikkelaars en gebruikers van hoog-risico AI-systemen, bijvoorbeeld als het gaat om transparantie en productveiligheid. Wij vinden het – net als het Europees Parlement – van belang dat er in deze wet speciale aandacht is voor foundation models en generatieve AI, zoals GPT en ChatGPT. Het kabinet zet zich ervoor in dat deze wet zo snel mogelijk wordt aangenomen. Op 14 juni jl. heeft het Europees Parlement gestemd over hun positie. Daarmee zijn de onderhandelingen in de laatste fase van de trilogen beland.

Ook in Raad van Europa-verband spannen wij ons in om een inhoudelijk sterk verdrag op te stellen. De groep van Raad van Europa-lidstaten is breder dan alleen de lidstaten van de EU en de ondertekening van dit verdrag staat ook open voor staten buiten het Europese continent. Het is belangrijk om op internationaal niveau afspraken te maken over verantwoordelijke ontwikkeling en gebruik van AI, ook met niet-EU landen.

De petitie stelt dat afgedwongen moet worden dat duidelijk is wanneer een uiting met AI tot stand is gekomen of wanneer een mens communiceert met AI. Ik ga onderzoeken hoe geregeld kan worden dat bij een besluit altijd wordt aangegeven of dit is gebaseerd op een algoritme of risicoprofilering. Daarbij betrek ik ook de motie van het lid Van Baarle en de recente oproep van het College voor de Rechten van de Mens voor een wettelijke transparantie-eis bij het algoritmegebruik door de overheid.46

Een voorgestelde maatregel in de petitie is om meer te investeren in onderzoek naar risico’s van AI. Ik kan zeggen dat we momenteel al volop investeren in AI-safety. Dit is een initiatief vanuit het Innovation Center for Artificial Intelligence (ICAI), dat wordt getrokken door de UvA in samenwerking met 51 partners uit bedrijfsleven, overheid, en de kennissector. Met een totaalbudget van 87 miljoen euro wordt volop geëxperimenteerd en onderzoek gedaan, in het bijzonder naar betrouwbare en uitlegbare AI-technologie. Ook zijn er labs waarin door wetenschappers, ondernemers en publieke instellingen – de ELSA-labs – onderzoek wordt gedaan naar de ethische, juridische en sociale aspecten van AI.

AI vraagt veel van de samenleving, het is daarom belangrijk dat de Nederlandse bevolking een goed beeld heeft over de kansen en uitdagingen van AI. De NL AI Coalitie heeft hiervoor een AI-cursus ontwikkeld die voor iedereen gratis beschikbaar is. We roepen dan ook zo veel mogelijk mensen op om deze cursus te volgen.

Met de hierboven geschetste acties zet het kabinet belangrijke stappen om te komen tot een verantwoorde toepassing van algoritmen in het overheidsdomein. Dat werk is voorlopig niet af. Enerzijds vanwege nieuwe wet- en regelgeving die in de maak is en anderzijds vanwege baanbrekende nieuwe ontwikkelingen rond AI en algoritmen, met onvoorziene mogelijkheden en risico’s voor mens en samenleving. Ik zie er naar uit om het gesprek met uw Kamer hierover voort te zetten.

De Staatssecretaris van Binnenlandse Zaken en Koninkrijksrelaties, A.C. van Huffelen

Universiteit van Utrecht (2020). Juridische aspecten van algoritmen die besluiten nemen. Considerati (2020). Onvoorziene effecten van zelflerende algoritmen. Bijlage bij Kamerstuk 26 643, nr. 726 https://www.rekenkamer.nl/publicaties/rapporten/2021/01/26/aandacht-voor-algoritmen en https://www.wrr.nl/publicaties/rapporten/2021/11/11/opgave-ai-de-nieuwe-systeemtechnologie.

High-level expert group on artificial intelligence | Shaping Europe’s digital future (europa.eu).

De AI-verordening is nog niet vastgesteld, voorlopig staat in de Raadstekst dat het gaat om contactgegevens, maar ook om onderdelen van de technische documentatie zoals de elektronische gebruiksaanwijzing. Ook een beschrijving van de beoogde doelen van het AI-systeem, de status (wel/niet in gebruik), de CE-markering of de EU-conformiteitsverklaring maken onderdeel uit van de informatie in de EU-databank.

Kamerstuk 35 925 VII, nr. 39, motie van het lid Van Baarle c.s. verzoekt te onderzoeken in hoeverre de handreiking non-discriminatie by design bekend is bij relevante overheidsdiensten en lokale overheden en te onderzoeken in hoeverre de aanbevelingen worden geïmplementeerd. Kamerstuk 26 643, nr. 829, motie van het lid Van Baarle c.s. verzoekt actief de kennis van de handreiking non-discriminatie by design te verspreiden onder private partijen die mogelijk aan afkomst gerelateerde persoonsgegevens verwerken.

Handreiking non-discriminatie by design | Rapport | Rijksoverheid.nl. (Bijlage bij Kamerstuk 26 643, nr. 765).

Master Data Science and Entrepreneurship (JADS, Den Bosch) en Executive learning Health (JADS).

Voorbeelden hiervan zijn Het Rijks I-Traineeship (RIT), Rijks ICT Gilde (RIG), Rijksacademie voor Financiën, Economie en Bedrijfsvoering (RAFEB), VNG Connect en LeerRijk.

Commissiedebat Inzet algoritmen en data-ethiek binnen de rijksoverheid d.d. 15 februari 2023 (Kamerstuk 26 643, nr. 982).

Een vorm van AI waarbij complexe algoritmen worden ingezet om nieuwe content te generen zoals tekst, afbeeldingen of video’s, en waarbij chatbot ChatGPT een bekende exponent vormt.

College voor de Rechten van de Mens. 29 juni 2023. Position Paper Transparantieverplichting voor overheid bij gebruik algoritmes.

Kopieer de link naar uw clipboard

https://zoek.officielebekendmakingen.nl/kst-26643-1056.html

De hier aangeboden pdf-bestanden van het Staatsblad, Staatscourant, Tractatenblad, provinciaal blad, gemeenteblad, waterschapsblad en blad gemeenschappelijke regeling vormen de formele bekendmakingen in de zin van de Bekendmakingswet en de Rijkswet goedkeuring en bekendmaking verdragen voor zover ze na 1 juli 2009 zijn uitgegeven. Voor pdf-publicaties van vóór deze datum geldt dat alleen de in papieren vorm uitgegeven bladen formele status hebben; de hier aangeboden elektronische versies daarvan worden bij wijze van service aangeboden.