Kamerstuk

| Datum publicatie | Organisatie | Vergaderjaar | Dossier- en ondernummer |

|---|---|---|---|

| Tweede Kamer der Staten-Generaal | 2020-2021 | 35848 nr. 2 |

Zoals vergunningen, bouwplannen en lokale regelgeving.

Adressen en contactpersonen van overheidsorganisaties.

U bent hier:

| Datum publicatie | Organisatie | Vergaderjaar | Dossier- en ondernummer |

|---|---|---|---|

| Tweede Kamer der Staten-Generaal | 2020-2021 | 35848 nr. 2 |

|

Inhoudsopgave |

blz. |

||||

|---|---|---|---|---|---|

|

Samenvatting |

2 |

||||

|

1. |

Inleiding |

3 |

|||

|

2. |

Politieke ontwikkelingen en huidige debat |

5 |

|||

|

2.1. |

Nationale ontwikkelingen en het AIV/CAVV rapport 2015 |

5 |

|||

|

2.2. |

Internationale ontwikkelingen |

7 |

|||

|

2.3. |

Europese ontwikkelingen |

8 |

|||

|

2.4. |

Conclusie |

9 |

|||

|

3. |

Autonome wapensystemen en betekenisvolle menselijke controle |

9 |

|||

|

3.1 |

Autonome wapensystemen |

9 |

|||

|

3.1.1. |

Definitie (volledig) autonoom wapensysteem |

9 |

|||

|

3.1.2. |

Ontwikkelingen in de tech-industrie |

10 |

|||

|

3.1.3. |

Algoritmen: voordelen en risico’s |

11 |

|||

|

3.1.4. |

Doelontwikkelingsproces |

12 |

|||

|

3.2 |

Betekenisvolle menselijke controle |

13 |

|||

|

4. |

Internationaal Humanitair Recht |

16 |

|||

|

4.1. |

Internationaal humanitair oorlogsrecht |

16 |

|||

|

4.1.1. |

Verbod op bepaalde categorieën wapens |

16 |

|||

|

4.1.1.1. |

Artikel 36-procedure |

17 |

|||

|

4.1.2. |

Beperkingen aan de inzet van autonome wapensystemen |

17 |

|||

|

4.1.2.1. |

Onderscheid |

18 |

|||

|

4.1.2.2. |

Proportionaliteit |

18 |

|||

|

4.1.2.3. |

Voorzorg |

19 |

|||

|

4.2. |

Aansprakelijkheid bij inzet autonome wapensystemen |

19 |

|||

|

4.3. |

Conclusie inzake (beperkingen aan de inzet van) autonome wapensystemen |

19 |

|||

|

5. |

Politieke maatregelen voor beheersing van autonome wapensystemen |

21 |

|||

|

5.1. |

Internationaal verdrag |

21 |

|||

|

5.2. |

Artikel 36-Procedure |

22 |

|||

|

5.3. |

Doelontwikkelingsproces |

22 |

|||

|

5.4. |

Wapenindustrie en ontwikkeling van wapensystemen |

22 |

|||

|

5.5. |

Dataregistratie |

23 |

|||

|

5.6. |

Aparte risicovermelding |

23 |

|||

|

6. |

Beslispunten |

23 |

|||

|

7. |

Financiële consequenties |

24 |

|||

Tussen mens en machine zit anno 2021 nog een groot verschil, maar tegelijkertijd zien we ook dat robots langzamerhand veel van de taken van de mens overnemen. Automatisering gebeurt al eeuwen, en op grote schaal. Robots worden overal ingezet ten behoeve van de mens. De taakverdeling was duidelijk: de robots doen het zware werk, en de mens zit aan de knoppen. Deze taakverdeling is echter niet langer vanzelfsprekend. Inmiddels zijn er vele geautomatiseerde systemen die hun werk vele malen beter doen zonder de helpende hand van de mens. Dit maakt de vraag over de taakverdeling tussen mens en machine actueler dan ooit. Welke beslissingen moeten we als mens zelf blijven nemen? En welke kunnen we delegeren aan een robot? Kunnen we robots wel vertrouwen en wie is er aansprakelijk als er iets misgaat?

Razendsnelle ontwikkelingen op het gebied van militaire technologie maken dat deze vragen ook gesteld moeten worden over het gebruik van geweld. Want mag een robot zelf beslissen geweld in te zetten? Zo ja, wanneer is dit toegestaan? Deze vraag doet zich onder meer voor bij de discussie over autonome wapensystemen. Volgens de initiatiefneemster ligt het antwoord op deze vraag bij de term betekenisvolle menselijke controle, wat betekent dat de mens verantwoordelijk blijft voor beslissingen die een morele afweging vereisen. Hier verschilt de mens namelijk fundamenteel van de machine. In deze initiatiefnota wordt nader ingegaan op autonome wapensystemen en de betekenisvolle menselijke controle.

Autonome wapensystemen selecteren en vallen doelen aan op basis van sensor input. Nadat het systeem door een mens is ingezet, is er geen directe input meer van een mens (zoals de Goalkeeper). Een volledige autonoom wapensysteem (killer robot) selecteert en valt ook doelen aan op basis van sensor input, maar staat niet onder betekenisvolle menselijke controle.

De initiatiefneemster stelt vast dat het kabinet al de nodige stappen op dit onderwerp heeft gezet maar dat dit nog niet volstaat. Het is noodzakelijk om snel concrete invulling te geven om de ontwikkeling en het gebruik van volledig autonome wapensystemen te stoppen, voordat het te laat is. Naast een gebrek aan urgentie constateert de initiatiefneemster een gebrek aan operationele en normatieve kaders.

De initiatiefneemster stelt in deze nota dat de huidige (internationale) wet- en regelgeving over autonome wapensystemen geen concrete invulling geeft aan de term betekenisvolle menselijke controle. De initiatiefneemster roept op tot een internationaal verdrag die betekenisvolle menselijke controle bij autonome wapensystemen garandeert en volledig autonome wapensystemen verbiedt.

Beslispunten:

1. Stel een internationaal verdrag op dat de inzet van autonome wapensystemen reguleert door betekenisvolle menselijke controle te garanderen en volledige autonome wapensystemen verbiedt. Hierbij dient een concrete invulling van het concept betekenisvolle menselijke controle als ijkpunt te worden genomen.

2. Roep de Nederlandse regering op om internationaal, vooral binnen de EU, aan te dringen bij andere landen om artikel 36 van het aanvullend Protocol 1 bij de verdragen van de Geneefse conventie 12 augustus 1949 om te zetten in nationale wetgeving.

3. Kom met een expliciete vermelding welke stappen binnen het doelontwikkelingsproces uitgevoerd moeten worden door een mens. Inzet van wapens die daar niet aan voldoen moet niet worden toegestaan.

4. Geen investeringen en steun van de Nederlandse regering voor de ontwikkeling van volledige autonome wapensystemen, zowel in Nederland, de Europese Unie (Europees Defensiefonds) als binnen de NAVO. Nederland dient zich actief in te zetten om dit soort investeringen te voorkomen.

5. Zorg dat alle autonome wapensystemen die door Nederland ontwikkelt of aangeschaft worden kunnen worden voorzien van een instrument dat data registreert en verzendt naar een database.

6. Zie het gebruik van niet-volledige autonome wapensystemen bij militaire missies als aandachtspunt bij de artikel 100 procedure.

In de gedemilitariseerde zone tussen Noord- en Zuid-Korea staat de Samsung SGR-A1 «guard robot». Een wapensysteem dat de optie heeft om autonoom te opereren en uitgerust is met lasers, thermografische camera’s, verlichting, een K3 LMG machinegeweer met magazijnen van 1000 kogels en een granaatwerper.1 Dit systeem is volledig ingericht op beweging in de gedemilitariseerde zone. Dit betekent dat het zal proberen alle vijandelijke dreigingen en bewegingen koste wat het kost uit te schakelen. Het wordt nu gebruikt op een manier waarbij een mens een aanval moet goedkeuren, maar het systeem heeft ook een optie waarbij het volledig autonoom opereert en het dus zelf mag beslissen wanneer de trekker wordt overgehaald. Niet alleen op de Koreaanse peninsula worden autonome wapensystemen gebruikt. De Turkse krijgsmacht bestelde vorig jaar vijfhonderd «Kargu» zwermdrones – een «kamikazedrone» die zelfstandig kan navigeren, doelwitten selecteren, en vernietigen. De Kargu-drone kan in een zwerm opereren, waardoor zo’n twintig tot dertig drones zich tegelijkertijd in een doelwit boren om zichzelf op te blazen.2 Volgens een rapport van de VN is de Kargu in Libië gebruikt.3 Ook de Amerikaanse, Franse, Engelse, Spaanse en Russische krijgsmacht ontwikkelen op dit moment zulke zwermdrones.4

De SGR-A1 en Kargu-drone zijn voorbeelden van wapensystemen die steeds autonomer worden. De zorg hierbij is hoe we als mens de controle blijven behouden over het gebruik van geweld. Ook rijst de vraag waar we de grens trekken. De technologie ontwikkelt zich razendsnel, zonder adequate regulering dreigen we de grens te overschrijden naar volledig autonome wapens, zogenaamde «killer robots».

Experts waarschuwen dat deze killer robots een derde revolutie in oorlogsvoering zullen ontketenen, waarbij de snelheid en de schaal van het geweld naar nieuwe hoogten zal schieten. De inzet van killer robots door terroristen, dictators of andere kwaadwillenden is geen complete illusie. Dit is een doemscenario waar op dit moment nog te weinig aandacht voor is. Het tijdig en breed voeren van de politieke discussie over dit soort autonome wapensystemen is van groot belang in het bredere debat over de toekomst van defensie en veiligheid. De initiatiefneemster zet in deze nota uiteen waarom dit belangrijk is en stelt enkele maatregelen voor om deze problematiek aan te pakken.

Het standpunt van de Nederlandse regering luidt dat betekenisvolle menselijke controle onderdeel moet zijn van autonome wapensystemen.5 Er is echter onduidelijkheid over de precieze betekenis van die betekenisvolle menselijke controle en in hoeverre dit doorwerkt in de daadwerkelijke wapensystemen en protocollen. Er lijkt vooralsnog te veel ruimte te zijn om voorbij te treden aan tal van juridische en ethische aspecten, die wat de initiatiefneemster betreft onlosmakelijk verbonden zijn aan de ontwikkeling, productie en het gebruik van autonome wapensystemen.

De initiatiefneemster is van mening dat de uiteindelijke beslissing over geweld – in het bijzonder over leven en dood – in oorlogsvoering door een mens genomen dient te worden en tevens op een betekenisvolle manier door een mens gecontroleerd moet worden. Computersystemen mogen deze beslissing nooit nemen. Het grote gevaar bij de ontwikkeling van autonome wapens is dat het autonome wapen een vorm van «moral agency» toegekend wordt, die het wapensysteem per definitie niet heeft. Er is immers geen sprake van een menselijk vermogen om verantwoorde morele keuzes te maken. Een mens beschikt wel over moral agency en kan daarom wél dergelijke beslissingen nemen. Mensen kunnen namelijk een afweging maken tussen alle omstandigheden en morele aspecten die hierbij komen kijken. Een autonoom wapensysteem kan vooralsnog niet – maar wellicht nooit – beschikken over moral agency. Uit een recent onderzoek van IPSOS (februari 2021) blijkt dat 59,2% van de Nederlanders tegen het gebruik van volledig autonome wapensystemen in oorlogen is. Het meest genoemde argument voor een verbod is het feit dat dit een morele lijn zou overschrijden.6

Het is niet zo dat de meest geavanceerde krijgsmachten op de wereld beschikken over een enorme vloot volledig autonome wapensystemen en dat deze bij een volgend conflict direct ingezet kunnen worden. Echter concludeerde een rapport van de AIV/CAVV (2015) wel dat «het niet langer denkbeeldig is dat op langere termijn volledig autonome wapensystemen met kunstmatige intelligentie worden ontwikkeld met functies zoals doelselectie en toepassing van (dodelijk) geweld, zonder tussenkomst van menselijk handelen.»7 Dit roept tal van (internationale) politieke, ethische en juridische vragen op waar de Nederlandse regering, laat staan een internationale coalitie, sinds het AIV/CAVV rapport van 2015 nog niet veel concrete invulling aan heeft gegeven. Aangezien volledig autonome wapensystemen (nog) niet bestaan, is dit hét moment om politieke kaders te schetsen.

Waar de technologische ontwikkelingen in de internationale militaire industrie de afgelopen jaren in een stroomversnelling zijn geraakt, is het de politiek nog niet gelukt om woorden om te zetten in daden.8

De initiatiefneemster stelt vast dat het kabinet al de nodige stappen op dit onderwerp heeft gezet maar dat dit nog niet volstaat. Het is noodzakelijk om snel concrete invulling te geven om de ontwikkeling en het gebruik van volledig autonome wapensystemen te stoppen, voordat het te laat is. Zo is een nadere invulling van de operationele en normatieve kaders noodzakelijk en mag de urgentie hiervan niet worden onderschat.

Gebrek aan operationele kaders

Het is een feit dat technologische ontwikkelingen altijd sneller gaan dan politieke besluitvorming. Net als met de komst van kernwapens is het zaak dat de politiek de kaders schept voor de manier waarop autonome wapens worden ingezet. Zo neemt de politiek haar verantwoordelijkheid door ruimte te geven, maar vooral ook door grenzen te stellen aan industrieën, bondgenoten en het eigen Ministerie van Defensie. Zo weten stakeholders wat het speelveld is en schept de politiek duidelijkheid.

Gebrek aan normatieve kaders

Het kabinet Rutte III benadrukte dat voor kunstmatige intelligentie alle wapensystemen te allen tijde onder betekenisvolle menselijke controle moeten staan, wat de aanwezigheid van moral agency zou moeten garanderen.9 Dit uitgangspunt onderschrijft de initiatiefneemster. Dit voornemen van de regering is echter nog niet verder ingekleurd. Eveneens is nog niet duidelijk hoe moral agency en betekenisvolle menselijke controle er in de realiteit uit komen te zien. Het is dus van belang dat de Nederlandse politieke positie explicieter wordt, aangezien juist ook een maatschappelijk en politiek debat van belang is wegens de enorme impact op toekomstige oorlogvoering.

Gebrek aan urgentie

Na het AIV/CAVV rapport van 2015 gaf het kabinet aan dat autonome wapens geen probleem vormden, maar de internationale defensie-industrie zit niet stil. De technologische ontwikkelingen gaan razendsnel en dat in een tijd dat het multilaterale stelsel waarin internationale afspraken worden gemaakt onder druk staat. Als er nog langer gewacht wordt, dan bestaat de mogelijkheid tot een wapenwedloop. Getracht moet worden om een eventuele wapenwedloop te voorkomen, in plaats van om deze te winnen. De initiatiefneemster vindt dat het parlement zich niet moet laten overvallen en het moet aandurven om stelling te nemen.

Het idee dat met de ontwikkeling van killer robots een revolutie in oorlogsvoering wordt ontketend is angstaanjagend. Des te meer nu op dit gebied nog een gebrek aan antwoorden, beleidskaders, verantwoordelijkheid en urgentie bestaat. Gelukkig zijn autonome wapensystemen ook niet geheel onderbelicht geweest. Hieronder wordt aandacht besteed aan de (inter)nationale politieke ontwikkelingen die tot dusver hebben plaatsgevonden.

In 2015 verzochten de ministers van Buitenlandse zaken en Defensie de Adviesraad Internationale vraagstukken («AIV») en de commissie van Advies inzake Volkenrechtelijke vraagstukken («CAVV») te adviseren over autonome wapensystemen, wat het vaak genoemde AIV/CAVV rapport «Autonome Wapensystemen: De Noodzaak van Betekenisvolle Menselijke Controle» opleverde. Vervolgens kwam er op 19 november 2016 een reactie van het kabinet op de motie van Grashoff tijdens de begrotingsbehandeling van Buitenlandse Zaken. Het kabinet bevestigde de grote zorgen die de samenleving heeft over de ontwikkelingen van robotica en kunstmatige intelligentie in relatie tot wapensystemen. Het kabinet wees de mogelijke ontwikkeling en inzet van volledig autonome wapens op voorhand af, omdat deze niet over betekenisvolle menselijke controle beschikken. Het kabinet deelde echter wel de mening van de adviescommissie over de huidige onhaalbaarheid van een moratorium op volledig autonome wapensystemen. Het kabinet onderschrijft de argumenten die de adviescommissie hiervoor aanvoert.10 Niettemin blijft het van belang dit vraagstuk te blijven volgen en gezien de snelle technologische ontwikkelingen dit advies conform de aanbeveling over vijf jaar opnieuw tegen het licht houden. Vooralsnog is dit rapport nog niet verschenen.

Op 24 april 2019 wordt de regering door D66, VVD, CDA, CU, GroenLinks, PvdA, SGP en 50PLUS opgeroepen om met gelijkgezinde landen praktisch en realistisch aanjager te zijn van een zo breed gedragen en verstrekkend mogelijk verdrag of andere bindende internationale regelgeving ter beheersing van de productie, plaatsing, verspreiding en inzet van nieuwe potentiële massavernietigingswapens.11

Op 13 mei 2019 stuurt de Minister van Buitenlandse Zaken een brief aan de Kamer in het kader van de internationale veiligheidsstrategie, hierin wordt ook ingegaan op autonome wapensystemen. Het kabinet benadrukt dat voor kunstmatige intelligentie alle wapensystemen te allen tijde onder betekenisvolle menselijke controle moeten staan. Voor nucleaire systemen is het kabinet dan ook van mening dat om onbedoelde inzet te voorkomen nucleaire besluitvorming altijd onder politieke controle moet zijn, zonder technische of procedurele automatismen.

«Het kabinet onderstreept het belang van internationale samenwerking tot een verantwoorde omgang met digitale technologie, kunstmatige intelligentie en wapenbeheersing, zoals ook vastgelegd in artikel 36 van het aanvullend protocol bij de Verdragen van Genève. Mede daarom is Nederland vanaf het begin actief betrokken geweest in de discussie over Lethal Autonomous Weapon Systems binnen de Conventie voor Conventionele Wapens.»12

Op 20 september 2019 (Kamerstuk 33 694, nr. 48) gaat het kabinet in op de uitvoering van de motie Koopmans c.s. (Kamerstuk 33 494, nr. 43) waarin wordt ingegaan op het (internationale) beleid ter beheersing van de productie, plaatsing, verspreiding en inzet van nieuwe potentiële massavernietigingswapens. Het kabinet stelt dat het «geen voorstander is van het vatten van nieuwe technologieën in aanvullende regelgeving (bijvoorbeeld in een internationaal verdrag) enkel met mogelijke toekomstige wapensystemen in gedachte.»13 Volgens het kabinet «geldt voor het gebruik van nieuwe technologieën evenzeer het bestaande internationaal recht (zoals het humanitair oorlogsrecht en mensenrechten) als voor bestaande technologieën in wapensystemen.»14 Aanvullende wetgeving zou nuttige ontwikkelingen kunnen frustreren en bovendien zouden nieuwe technologieën te divers van aard zijn om in een alomvattend internationaal verdrag te vatten. Wat betreft autonome wapensystemen stelt het kabinet in deze brief dat het standpunt nog steeds grotendeels berust op het AIV/CAVV rapport uit 2015, en wordt de Nederlandse inzet in verscheidene internationale fora benadrukt.

Op 28 oktober 2020 komt na deze reactie op de uitvoering van motie Koopmans c.s. ook een officiële kabinetsreactie (Kamerstuk 33 494, nr. 59), waar de eerdere positie (en het AIV/CAVV rapport) wordt herhaald.15 Het kabinet stelt wel dat de context inmiddels anders is dan vijf jaar geleden, en benadrukt dat de ontwikkelingen op het gebied van technologie elkaar in hoog tempo opvolgen.

De initiatiefneemster constateert dat het kabinet de afgelopen jaren, zowel nationaal als internationaal, de bereidheid heeft getoond om de potentieel verstrekkende gevolgen van autonome wapensystemen te adresseren. Het omarmen van de term betekenisvolle menselijke controle was daarin een belangrijke stap, die liet zien dat de risico’s van autonome wapensystemen door het kabinet worden onderkent. De intitiatiefneemster is van mening dat dit onvoldoende is. Het schort aan een daadwerkelijke standpuntbepaling en de daadkracht om te handelen ontbreekt. De noodzakelijke normatieve en operationele kaders missen, en er is nog steeds geen concrete invulling van de term betekenisvolle menselijke controle. De tijd om te handelen is nu.

De inzet van autonome wapensystemen werd internationaal voor het eerst besproken tijdens de Human Rights Council in 2013, na een rapport van de VN Special Rapporteur Christof Heyns. Vervolgens is het onderwerp opgepakt door de UN Convention on Conventional Weapons (UNCCW), waar informele expertbijeenkomsten plaatsvonden in 2014, 2015 en 2016. Vanaf 2017 vinden de besprekingen plaats in de vorm van een Group of Governmental Experts (GGE) met een meer formeel mandaat.

Op 20 augustus 2017 wordt een open brief gestuurd naar het UNCCW, inzake het verbod of de beperking van het gebruik van bepaalde conventionele wapens die geacht kunnen worden buitensporig leed te veroorzaken of een niet-onderscheidende werking te hebben.16 Deze brief werd ondertekend door bedrijven die de technologie van AI en robots ontwikkelen, onder aanvoering van Tesla en SpaceX topman Elon Musk.17Hun oproep was helder:

«Lethal autonomous weapons threaten to become the third revolution in warfare. Once developed, they will permit armed conflict to be fought at a scale greater than ever, and at timescales faster than humans can comprehend. These can be weapons of terror, weapons that despots and terrorists use against innocent populations, and weapons hacked to behave in undesirable ways. We do not have long to act. Once this Pandora’s box is opened, it will be hard to close. We therefore implore the High Contracting Parties to find a way to protect us all from these dangers.»18

In 2019 werd besloten dat de GGE eind 2021 moet komen tot aanbevelingen over een normatief en operationeel kader voor autonome wapensystemen.19In mei 2020 benadrukte secretaris-generaal van de Verenigde Naties António Guterres dat er zo snel mogelijk afspraken moeten komen over limieten en verplichtingen wat betreft het toepassen van autonomie op wapensystemen.20

Daarnaast is er een grote inzet van NGO’s en de wetenschap geweest op het gebied van autonome wapensystemen. Al sinds 2012 waarschuwt de Campaign to Stop Killer Robots, een coalitie van 170 NGO’s uit 65 landen voor autonome wapensystemen. Daarnaast zijn er een groot aantal landen, 4.500 Artificial Intelligence (AI) experts en het Europees parlement die waarschuwen voor autonome wapensystemen en oproepen tot een internationaal verdrag.21 Meer recent riepen in december 2020 meer dan 170 Nederlandse wetenschappers op het gebied van kunstmatige intelligentie en robotica op tot een verbod op autonome wapens zonder betekenisvolle menselijke controle.22

Op 12 mei 2021 kondigde het Internationale Rode Kruis (ICRC) aan voor een internationaal verdrag over autonome wapens te zijn: «The ICRC is convinced that international limits should take the form of new legally binding rules to regulate autonomous weapons."23

In september 2018 onderschreef de Europese Unie een Resolutie (2018/2752 RSP) die de Hoge Vertegenwoordiger van de Unie oproept om een gezamenlijk positie ten aanzien van volledig autonome wapensystemen in te nemen, en zich daarnaast in te zetten voor internationale onderhandelingen om te komen tot een juridisch instrument om volledig autonome wapensystemen te verbieden.24

Op individueel niveau hebben landen binnen de Europese Unie al de nodige aandacht besteed aan autonome wapensystemen. In Finland, bijvoorbeeld, stelt het regeerakkoord uit 2019 dat het land zich zal inzetten voor onderhandelingen voor een verbod op wapens die gebruik maken van kunstmatige intelligentie.25 In het regeerakkoord uit 2020 van België staat: «Ons land neemt het initiatief om te komen tot een regelgevend kader inzake volledig autonome wapensystemen, en streeft daarbij naar een internationaal verbod.» 26 Ook Oostenrijk roept op tot een internationaal verdrag op autonome wapens zonder betekenisvolle menselijke controle. Naast Oostenrijk en België heeft ook Duitsland zich uitgesproken over autonome wapensystemen in het regeerakkoord uit 2018: «Autonome Waffensysteme, die der Verfügung des Menschen entzogen sind, lehnen wir ab. Wir wollen sie weltweit ächten.».27

De ontwikkelingen op het gebied van robotica en kunstmatige intelligentie gaan ontzettend snel. De internationale discussie over autonome wapensystemen is, mede dankzij de inzet van NGO’s en de wetenschap, inmiddels echt van start. Het mogelijke gevaar van killer robots wordt daarmee steeds meer bekend en de roep om kaders te stellen steeds sterker. De AIV/CAVV adviseerde de regering in 2015 dan ook om in 2020 met een nieuw rapport te komen over autonome wapensystemen.28

In dit hoofdstuk wordt ingegaan op wat autonome wapensystemen precies zijn. Hierbij wordt kort stilgestaan bij de snelle technologische ontwikkelingen en op de achterliggende militaire- en techindustrie. Tot slot wordt ingegaan op het belang en doel van betekenisvolle menselijke controle, die volgens de initiatiefneemster de garantie moet vormen voor het waarborgen van moral agency bij de inzet van autonome wapensystemen.

In deze sectie wordt ingegaan op de definitie van autonome wapensystemen en het onderscheid tussen volledige en niet-volledige autonome wapensystemen. Vervolgens worden de huidige ontwikkelingen in de techindustrie geadresseerd om aan te geven dat hier ontzettend veel gebeurt. Daarna zal worden ingegaan op (slimme) algoritmen, en worden bondig de voordelen en risico’s van algoritmen toegelicht. Ten slotte wordt het militaire concept «doelontwikkelingsproces» uiteengezet om aan te geven dat een krijgsmacht vele nauwkeurige stappen doorloopt, voordat over wordt gegaan tot het uitvoeren van een (aanvals)missie.

Een standaarddefinitie van autonome wapensystemen bestaat niet, deze initiatiefnota hanteert de definitie van het Internationale Rode Kruis (ICRC):

«Any weapon system with autonomy in its critical functions. That is, a weapon system that can select (i.e. search for or detect, identify, track, select) and attack (i.e. use force against, neutralize, damage or destroy) targets without human intervention.»29

Deze brede definitie van het ICRC staat zowel toe te spreken over de zorgen rondom huidige autonome wapensystemen, als ook over opkomende technologische ontwikkelingen op dit gebied die zorgwekkend kunnen zijn onder internationaal humanitair recht, voor de menselijke waardigheid en het menselijk geweten.30 Om deze discussie goed te begrijpen is het cruciaal om een duidelijk onderscheid te maken tussen autonome wapensystemen en volledig autonome wapensystemen.

Autonome wapensystemen selecteren en vallen doelen aan op basis van sensor input. Nadat het systeem door een mens is ingezet, is er geen directe input meer van een mens. Dit betekent dat waar en wanneer geweld wordt gebruikt wordt bepaald door sensoren in plaats van een mens. Het feit dat een wapensysteem voor een korte periode in een klein gebied autonoom opereert hoeft geen probleem te zijn, omdat de mens door beperkingen van tijd en ruimte controle behoudt over de effecten van een aanval. Dit is wat we betekenisvolle menselijke controle noemen. Dit is dus geen directe controle, maar door het instellen van bepaalde beperkingen in tijd, ruimte en soort doelwit etc, is de gebruiker in staat controle uit te oefenen op de mogelijke effecten.

Een volledig autonoom wapensysteem (killer robot) selecteert en valt ook doelen aan op basis van sensor input, maar kan niet met betekenisvolle menselijke controle gebruikt worden. Hierdoor heeft de mens onvoldoende invloed op de effecten van een wapensysteem. Voorbeelden hiervan zijn wapensystemen waar je geen beperkingen aan kan opleggen in tijd of ruimte, of wapensystemen die gebruik maken van machine learning, en op basis daarvan acties kunnen ondernemen zonder dat ze zijn goedgekeurd door een mens. In al deze gevallen kan je als mens niet meer de effecten van een aanval adequaat controleren. Het verschil zit dus in het feit dat bij laatstgenoemde geen betekenisvolle menselijke controle aanwezig is. In de Engelse passages in de tekst wordt gerefereerd naar AWS en LAWS, deze afkortingen staan respectievelijk voor autonomous weapon systems en lethal autonomous weapon systems. Deze worden synoniem gebruikt aan de Nederlandse termen autonome wapensystemen en volledig autonome wapensystemen.

«Techbedrijven investeren in dodelijke, autonome wapens» kopte het NRC in 2019. De ontwikkeling van kunstmatige intelligentie geeft techbedrijven een sleutelrol bij de ontwikkeling van killer robots.31 We spreken hier over wapensystemen zoals drones, onbemande voertuigen, schepen of vliegtuigen die zelfstandig kunnen opereren in oorlogsgebied, zonder directe menselijke input geweld kunnen gebruiken en zelf mensen kunnen doden. Qua technologie zijn deze killer robots inmiddels al meer realiteit dan fictie, en kunnen ze in principe ontwikkeld worden. Om te begrijpen hoe serieus de dreiging van volledig autonome wapensystemen is, is het goed te kijken naar de ontwikkelingen en productie van zulke wapensystemen door de industrie. Vredesorganisatie Pax onderzocht vijftig grote techbedrijven op het risico dat ze betrokken kunnen zijn bij de ontwikkeling en productie van volledig autonome wapensystemen. Ze ontdekten dat slechts zeven van de vijftig uitdrukkelijk hebben vastgelegd niet te willen werken aan de productie van volledig autonome wapensystemen. Tweeëntwintig bedrijven hebben niet vastgelegd dat ze volledig autonome wapensystemen ontwikkelen, maar laten wel weten dat ze er niet actief aan meewerken. De overige eenentwintig bedrijven werken wel samen met Defensie, maar lijken geen beleid te voeren op de manier waarop dit zou kunnen leiden tot volledig autonome wapensystemen. Deze samenwerkingen tussen ministeries van Defensie en techbedrijven zijn de motor achter de ontwikkeling van nieuwe soorten wapens waarbij algoritmen centraal staan. De manier waarop kunstmatige intelligentie en militaire technologie samenkomt wordt door experts gezien als een revolutie in oorlogsvoering.32

Een groot risico van (volledig) autonome wapensystemen, maar zeker ook voor de digitale revolutie in het algemeen, zijn hackrisico’s. Met de snelle technologische ontwikkelingen en de grotere afhankelijkheid van online en digitale systemen worden de kansen op hacks alleen maar groter, met alle mogelijke gevolgen van dien. Als het gaat om (volledig) autonome wapensystemen kunnen hacks grote (geo)politieke of militaire conflicten veroorzaken. In het kader van volledig autonome wapensystemen speelt de discussie over aansprakelijkheid ook een grote rol. Want wie is er verantwoordelijk voor een gehackte killer robot? Ook al zijn hackrisico’s wezenlijk, op dit moment zijn volledig autonome wapensystemen nog niet ontwikkeld. Daarom is het moeilijk om hierop vooruit te lopen. Desalniettemin wil de initiatiefneemster hier wel op wijzen, omdat hackrisico’s ook van toepassing zijn op andere (autonome) wapens.33

De ontwikkeling van algoritmen gaat ontzettend hard. In de context van autonome wapensystemen spreken we over «zelflerende» of «slimme» algoritmen. Het gaat hier om (delen van) computersystemen die zelf beslissingen kunnen nemen, dit wordt ook wel kunstmatige intelligentie genoemd. De Europese Commissie definieert kunstmatige intelligentie als: «systems that display intelligent behaviour by analysing their environment and taking actions – with some degree of autonomy – to achieve specific goals.»34 Slimme algoritmen gaan de komende decennia een centrale rol spelen in technologische ontwikkelingen en zullen ongetwijfeld veel voordelen opleveren voor de mens. Op dit moment zijn er echter ook nog een aantal haken en ogen aan slimme algoritmen. Het voornaamste probleem is de menselijke bias die onherroepelijk terug te vinden is in algoritmen. Dit ligt niet aan het algoritme zelf, maar aan het feit dat een mens het algoritme geprogrammeerd heeft. Dit kan bijvoorbeeld leiden tot algoritmen die uit zichzelf discriminerende keuzes maken. Een tweede probleem met het inzetten van slimme algoritmen is het gebrek aan transparantie in de besluitvorming. Door de complexiteit van de keuzes gaat het vaak de menselijke pet te boven en worden algoritmen een zwarte doos. We zien en snappen niet hoe we van A tot B komen. In de discussie over autonome wapensystemen wordt vaak de vraag gesteld in hoeverre slimme algoritmen het menselijk handelen zouden kunnen overnemen.35

Nieuwe technologische ontwikkelingen zijn eigenlijk altijd ten behoeve van de mens. Van de koelkast en wasmachine tot de MRI- en röntgenscans, allemaal bedacht om de handelingen en de levens van mensen te verbeteren. In oorlogsvoering is het niet heel anders, het geven van autonomie aan systemen betekent dat computers het werk van de mens kunnen overnemen. Voor veel taken is dit natuurlijk geen probleem. Sterker nog, het is in veel gevallen juist goed dat militairen in steeds grotere mate kunnen rekenen op slimme systemen. Er zijn immers ook veel taken die computers simpelweg beter kunnen dan mensen. Autonome wapensystemen en robots zijn zulke nieuwe technologische ontwikkelingen en bieden ook mogelijkheden voor Defensie om het werk beter, veiliger en efficiënter te doen. Al in de koude oorlog werden er wapensystemen met autonome functies ontwikkeld, zoals het patriot-luchtverdedigingssysteem. Dit systeem werd bijvoorbeeld veel gebruikt in de eerste Golfoorlog en is in staat ballistische raketten te onderscheppen.

Veel moderne wapensystemen hebben autonome functies gekregen, bijvoorbeeld het opstijgen of landen van een drone. Een wapensysteem heeft tal van functies die ervoor zorgen dat het zijn taken kan uitvoeren. Hierin kan een onderscheid worden gemaakt tussen algemene functies (zoals het meten van de buitentemperatuur) en kritieke functies (zoals het selecteren van vijandelijke doelwitten). De focus in deze initiatiefnota ligt voornamelijk bij de autonomie in de kritieke functies.

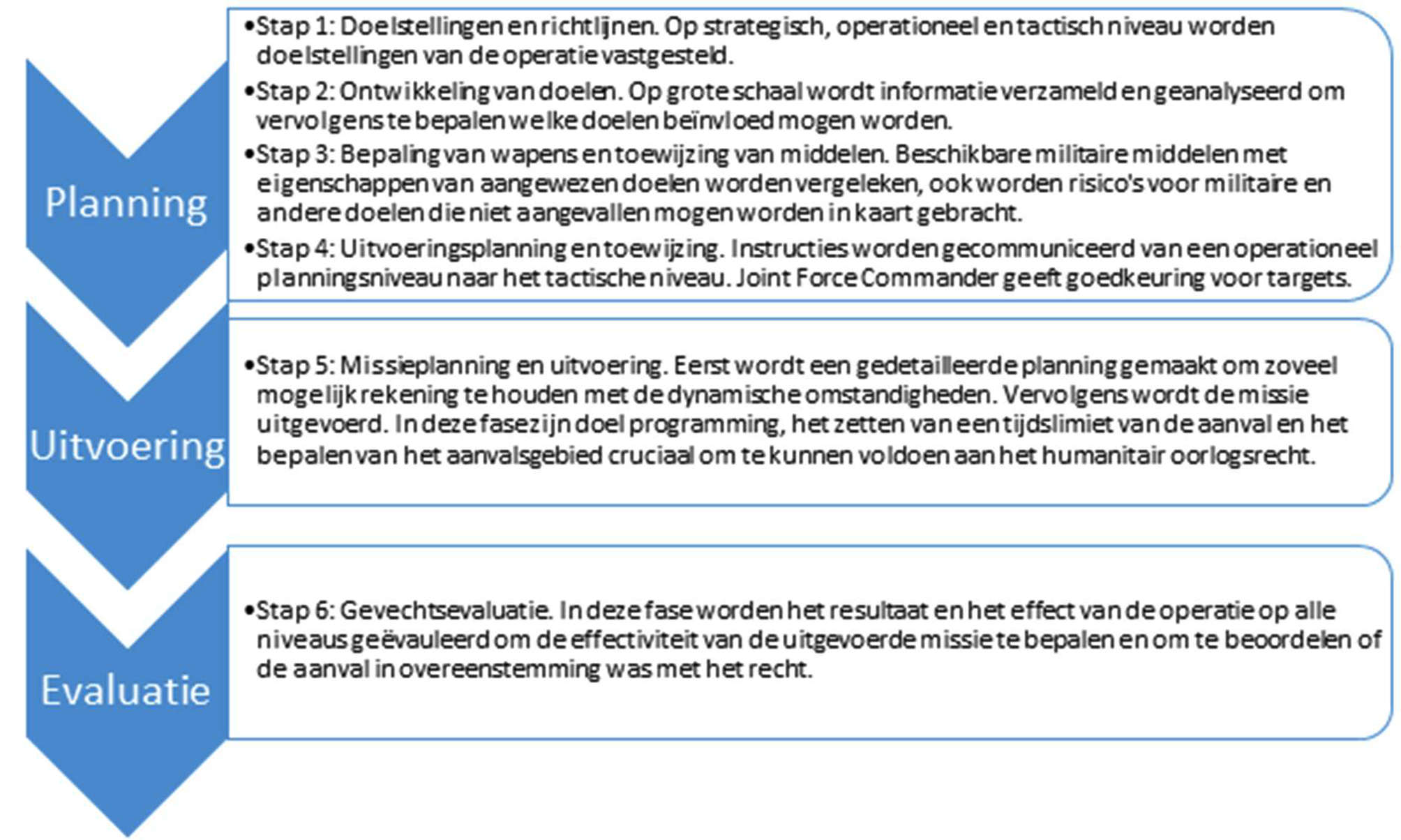

In figuur 1 wordt het zogenaamde doelontwikkelingsproces uiteengezet, waarin wordt beschreven welke verschillende fases worden doorgelopen in het vaststellen van een doelwit en het voorbereiden van een aanval.

Figuur 1: Samenvatting van het NAVO targeting-proces (doelontwikkelingsproces)

De positieve gevolgen van het gebruik van autonome wapensystemen zijn dan ook dat ze veel van de processen kunnen versnellen en bepaalde interrelaties in de gebruikte data herkennen die voor het menselijk brein niet te bevatten zijn.36 Tegelijkertijd zitten er ook grote risico’s aan het gebruik van autonome wapensystemen, en de onderliggende technologieën die daarvoor gebruikt worden. Autonome technologieën veranderen de activiteiten van mensen. Deze technologieën vervangen de taken van de mensen niet helemaal, vaak vullen ze de rol van de mens aan. Denk aan het verbeteren van omgevingsbewustzijn of een betere inschatting van de operationele kaders. Dit gaat echter met risico’s gepaard. Als de overdracht van besluitvormingsprocessen van mens op machine niet grondig is doordacht kunnen er situaties ontstaan waar er (onverhoopt) verlies van menselijke controle is over cruciale gevechtshandelingen. De vraag of de mens controle houdt over kritieke keuzes hangt af van de mate waarin men erin slaagt om een framework te creëren waarin de taakverdeling tussen de mens en autonome technologieën goed is vastgelegd.37

Zoals beschreven in hoofdstuk twee zijn er reeds veel landen en organisaties die pleiten voor een duidelijker framework voor betekenisvolle menselijke controle. Ook onder de bevolking zijn er zorgen over volledig autonome wapensystemen. IPSOS onderzocht in februari 2021 in 28 landen wat de bevolking vond van volledig autonome wapensystemen. Hieruit blijkt dat 61% van de ondervraagden tegen volledig autonome wapensystemen is. Van de onderzochte groep geeft 66% van de ondervraagden aan tegen volledig autonome wapensystemen te zijn omdat dit een morele lijn overschrijdt. Machines zouden niet over keuzes van leven en dood mogen gaan. Daarnaast is 53% van de mensen die tegen autonome wapensystemen zijn, bezorgd omdat autonome wapens geen rekenschap kunnen afleggen.38 Uit hetzelfde onderzoek blijkt dat 59,2% van de Nederlanders tegen het gebruik van volledig autonome wapensystemen in oorlogen is. Ook in Nederland is het meest genoemde argument dat zulke wapensystemen een morele lijn zouden overschrijden.39

Als we het over een mogelijk framework hebben om de taakverdeling tussen mens en machine in te kaderen, dan is het concept betekenisvolle menselijke controle weer van cruciaal belang. Het doel van betekenisvolle menselijke controle is dat de mens controle behoudt over de effecten van een aanval op een doelwit en de omgeving, en dat deze effecten in lijn zijn met haar/zijn intenties. In relatie tot autonome wapensystemen moet betekenisvolle menselijke controle voornamelijk plaatsvinden tijdens het doelontwikkelingsproces. Maar ook eerder, tijdens de ontwerp en ontwikkelfase van een wapensysteem dient betekenisvolle menselijke controle een centrale rol te spelen. Het ICRC stelt hierover:

«1. The user must have reasonable certainty about the effects of the AWS in the specific environment of use. That means the human must have sufficient understanding of both the environment of use and the AWS to be able to make the judgements required from legal, ethical and operational perspectives.

2. The users must exercise judgement and intent–or agency–in the use of force in specific attacks, both to ensure compliance with IHL and to uphold moral responsibility and ensure accountability for the consequences. This means the human user must exert effective influence over the functioning of the AWS in a specific attack.»40

Dit onderwerp staat ook in Nederland al sinds 2015 op de politieke agenda. In de kabinetsreactie op het AIV/CAVV rapport uit 2015 onderschrijft het kabinet dat betekenisvolle menselijke controle noodzakelijk is bij de inzet van autonome wapensystemen. Maar wat betekent dat concreet? Er is geen eenduidige definitie voor betekenisvolle menselijke controle, maar er is wel een brede consensus over zeven elementen die het concept bevat:

• Controle over de context (bijvoorbeeld door beperkingen in tijd en ruimte van inzet)

• Het door de gebruiker begrijpen van het functioneren van het wapensysteem

• Het door de gebruiker begrijpen van de omgeving van de mogelijke aanval

• Voorspelbaarheid en betrouwbaarheid van het wapensysteem

• Menselijk toezicht en mogelijkheden tot ingrijpen

• Verantwoording door een mens

• Ethische overwegingen en het principe van menselijke waardigheid41.

Bij het formuleren van betekenisvolle menselijke controle aangaande autonome wapensystemen dient – door de mens – stilgestaan te worden bij deze zeven elementen. Dit betekent grondige controle, kennis en toezicht over het wapensysteem zoals reeds is vastgelegd in het doelontwikkelingsproces voor niet-volledige autonome wapensystemen. Tevens moet de menselijke aanwezigheid garanderen dat het (menselijke) vermogen aanwezig is om moreel verantwoorde afwegingen en beslissingen te kunnen maken. In andere woorden, er moet een garantie zijn dat moral agency deel is van de besluitvorming in het doelontwikkelingsproces. Hoogleraar Internationale Betrekkingen Desiree Verweij van Radboud Universiteit Nijmegen noemt dit het ontwikkelen van morele professionaliteit.42 Dit betekent dat een militair de competenties ontwikkelt om met de morele aspecten van een militaire context om te gaan:

• Bewust worden van de eigen, persoonlijke waarden en de waarden van anderen;

• In staat zijn de morele dimensie van een situatie te herkennen en kunnen zien welke waarden op het spel staan;

• Kunnen oordelen over een morele vraag;

• Over dit oordeel kunnen communiceren;

• Willen en kunnen handelen naar dit oordeel op een moreel verantwoorde manier;

• Verantwoording willen en kunnen afleggen aan jezelf en aan anderen.43

De initiatiefneemster onderschrijft deze invulling van morele professionaliteit en stelt dat deze aanwezig moet zijn in het doelontwikkelingproces. Daarnaast dient er ook expliciet te worden stilgestaan bij het principe van menselijke waardigheid. Het is belangrijk te benadrukken dat het niet enkel moet gaan over de vraag of zulke wapens in de huidige juridische kaders van oorlogvoering passen, maar juist ook over de mate waarin we deze ontwikkeling, als mensheid, acceptabel vinden. Juist de bezorgdheid over het verlies van menselijke controle over wapensystemen en het gebruik van geweld gaat verder dan vragen over de compatibiliteit van autonome wapensystemen met onze wetten. Het omvat fundamentele vragen over de mate waarin zulke wapensystemen aanvaardbaar zijn voor onze menselijke waarden.44Zoals het ICRC stelt «[h]uman agency in that decision-making process is required to uphold moral responsibility for that decision in recognition of the human dignity of those affected, whether combatants or civilians.»45 Het aan machines overlaten van beslissingen over leven en dood is in strijd met de overtuiging dat wij mensen als enige moral agency hebben en dus enkel mensen beslissingen kunnen maken waarbij we rekenschap hebben van de mens die erdoor geraakt wordt. Enkel de mens is in staat deze morele verantwoordelijkheid te dragen. Dit maakt dat menselijke controle altijd nodig is en daarmee autonome wapensystemen de beslissing over leven en dood niet kunnen maken.

Betekenisvolle menselijke controle is een onlosmakelijk en als zodanig eveneens zorgelijk aspect bij de inzet van automatische wapensystemen. Burgers maken zich zorgen over morele kwesties: kan een machine keuzes met betrekking tot leven en dood worden toevertrouwd en kan een machine daar verantwoording over afleggen?46 Ook op internationaal niveau worden deze zorgen gedeeld en bestaat er consensus over de noodzaak van menselijke betrokkenheid bij wapeninzet. In het internationaal humanitair recht is hieromtrent het nodige nog niet geregeld.47 Alvorens te kijken of er noodzaak bestaat tot aanvullende regulering is het van belang om te weten wat binnen het bestaande oorlogsrecht al gereguleerd is.

Het oorlogsrecht kan onderscheiden worden in twee rechtsgebieden: jus ad bellum en jus in bello. Jus ad bellum heeft betrekking op de situatie voorafgaand aan een gewapend conflict – is het voeren van oorlog gerechtvaardigd? Internationaal humanitair recht, ook wel jus in bello, ziet toe op de situatie ten tijde van gewapende conflicten, dat onder meer het voeren van vijandelijkheden, de toepassing van middelen en methoden van oorlogsvoering reguleert. Het beschouwt een conflict dus als een realiteit, zonder te kijken naar de redenen of rechtmatigheid van het overgaan tot geweld. Het stelt uitsluitend regels aan de humanitaire aspecten van het conflict.

Bij de inzet van autonome wapensystemen is dan ook met name het jus in bello relevant. Binnen het internationaal humanitair oorlogsrecht kunnen bepaalde wapens of de inzet van bepaalde wapens verboden zijn.

In het internationaal humanitair oorlogsrecht zijn drie categorieën van wapens verboden:

• wapens die onnodig leed en/of buitensporige verwondingen veroorzaken;48

• wapens die een niet-onderscheidend vermogen hebben, ofwel waar bij de inzet ervan geen onderscheid kan worden gemaakt tussen militaire doelen (personen en objecten) enerzijds en burgers en burgerobjecten anderzijds;49

• wapens waarvan de effecten onbeheersbaar zijn, waardoor zowel burgers als vijandelijke combattanten zonder onderscheid geraakt worden.50

Onder de eerste categorie wapens (onnodig leed en/of buitensporige verwondingen) worden onder meer laserwapens die permanente blindheid veroorzaken verstaan of munitie van handwapens die bij contact met het menselijke lichaam ontploft. Bij de tweede categorie wapens (niet-onderscheidend vermogen) kan gedacht worden aan bacteriologische wapens of bepaalde soorten mijnen of booby traps. Een voorbeeld uit de derde categorie wapens (onbeheersbare effecten) is een computervirus dat een communicatiesysteem uitschakelt, waarbij vervolgens geen onderscheid gemaakt kan worden tussen het platleggen van het militaire communicatiesysteem en het communicatiesysteem van hulpdiensten.

Een autonoom wapensysteem is niet per definitie verboden. Er is namelijk geen reden om aan te nemen dat autonome wapensystemen onder één van de bovengenoemde verboden categorieën wapens vallen. Het gemeenschappelijke element van autonome wapensystemen – de beschikking over autonome kritische functies – is niet aan banden gelegd en is dan ook niet bepalend voor de vraag of bepaalde autonome wapensystemen verboden zijn of niet. Wel kan een autonoom wapensysteem een verboden wapen dragen, zoals laserwapens die permanente blindheid veroorzaken. Of een autonoom wapensysteem als verboden wapen aangemerkt kan worden, moet daarom per specifiek wapen beoordeeld worden.51 52

In artikel 36 van het Eerste Aanvullende Protocol bij de Geneefse Verdragen is deze toets voorgeschreven bij de ontwikkeling en aanschaf van nieuwe wapens en middelen, waaronder dus ook autonome wapensystemen. In Nederland geeft een commissie advies aan de Minister van Defensie inzake de verenigbaarheid van onder meer het verwerven, bezit en gebruik van conventionele wapens en munitie soorten.53

In sommige gevallen, specifiek met betrekking tot autonome wapensystemen, vinden toetsingen niet, of pas in een laat stadium plaats. Dit komt doordat de technologie waarop de autonome wapensystemen gebaseerd zijn, in veel gevallen dual-use is. Het kan zowel voor civiele als militaire doeleinden gebruikt worden. Daardoor ligt militair gebruik niet altijd voor de hand, maar is het wel mogelijk. Desalniettemin rust er wel een verplichting op staten om deze juridische toetsing uit te voeren.54

Bepaalde categorieën wapens kunnen dus verboden zijn onder het internationaal (humanitair oorlogs)recht, waaronder ook bepaalde autonome wapensystemen. Naast deze wapenverboden stelt het internationaal humanitair oorlogsrecht eisen aan het voeren van vijandelijkheden en de inzet van wapens. Deze eisen zijn onverkort van toepassing op autonome wapensystemen.55

Een belangrijk uitgangspunt hierbij is dat de verantwoordelijkheid voor het vellen van een juridisch oordeel over een aanval, bij de mens zou moeten liggen. Het ICRC stelt hierover: «It is the humans subject to IHL who are responsible for applying the law and who can be held accountable for violations, not the weapon itself. The legal requirements under rules governing attacks must be fulfilled by those persons who plan, decide on and carry out attacks, in other words the users of an AWS.»56

Allereerst dient bij de inzet van (autonome) wapensystemen een onderscheid te worden gemaakt tussen militaire doelen enerzijds en burgers en burgerobjecten anderzijds. Burgers en burgerobjecten mogen logischerwijs niet het doel zijn van een aanval. Een aanval mag enkel gericht zijn op een militair doel. Leden van vijandige strijdkrachten, leden van georganiseerde gewapende groeperingen met een een doorlopende gevechtsfunctie en burgers die tijdelijk rechtstreeks deelnemen aan vijandelijkheden zijn personen die als militair doel gelden. Objecten die als militair doel gelden, zijn objecten die door hun aard, locatie, bestemming of gebruik een daadwerkelijke bijdrage aan de missie leveren en waarvan de gehele of gedeeltelijke vernietiging, verovering of onbruikbaarmaking onder de omstandigheden van dat moment een duidelijk militair voordeel oplevert. Voorts verdient opmerking dat alle personen en objecten die niet onder de omschrijving van een militair doel vallen, burgers of burgerobjecten zijn en daarmee geen doel van een aanval mogen zijn.57

Alhoewel bovenstaande uitgangspunten duidelijk geformuleerd zijn, is de context waarin deze situaties zich voordoen vaak minder duidelijk. Bijvoorbeeld wanneer de militaire doelen geen militairen in vol ornaat zijn, maar bijvoorbeeld leden van georganiseerde gewapende groeperingen die zich onder de burgerbevolking begeven. Of het onderscheid tussen een vijandelijke combattant en een persoon die buiten gevecht is gesteld door een verwonding of capitulatie. Bestaande autonome wapensystemen, zoals de Goalkeeper en de Patriot, zijn dan ook stationair en worden defensief ingezet. Zij zijn enkel in staat om voorgeprogrammeerde doelen te herkennen en opereren in relatief overzichtelijke zones.

Bepalend voor de vraag of een autonoom wapensysteem ingezet kan worden in overeenstemming met het beginsel van onderscheid is de omgeving waarbinnen het systeem opereert, de bekwaamheid van het systeem om onderscheid te maken en de voorzorgsmaatregelen die de commandant zal nemen bij inzet.

Naast het beginsel van onderscheid dient de inzet van een (autonoom) wapen(systeem) ook in overeenstemming te zijn met het proportionaliteitsbeginsel. Proportionaliteit wordt in het humanitair oorlogsrecht gedefinieerd als een aanval op een militair doel waarvan verwacht mag worden dat het verlies aan burgerlevens, letsel aan burgers en/of schade aan burgerobjecten buitensporig zou zijn ten opzichte van het concrete en directe militaire voordeel dat de aanval zou opleveren. Er dient dus eerst in kaart te worden gebracht wat de verwachte nevenschade is voordat een afweging kan worden gemaakt. Het berekenen van de nevenschade kan in bepaalde gevallen nauwkeuriger worden vastgesteld door daartoe ontwikkelde software. Het maken van de kwalitatieve afweging is echter een taak die aan de mens is toebedeeld. Daarnaast is het in het kader van juridische en morele verantwoordelijkheid van belang dat de mens de uiteindelijke beslissing neemt. Dus software kan de beslissing van de mens ondersteunen, maar de eindverantwoordelijkheid moet bij de mens liggen. Deze rolverdeling en met name de verplichting om de kwalitatieve afweging bij de mens te laten berusten, is echter niet als zodanig juridisch vastgelegd.

Net zoals bij het beginsel van onderscheid geldt ook hier dat de context bepalend is voor de vraag of inzet van autonome wapensystemen in overeenstemming met het proportionaliteitsbeginsel kan zijn. Indien nevenschade wordt verwacht of indien de mens niet in staat is om de kwalitatieve afweging te maken (en het autonoom wapensysteem mogelijkerwijs een achteraf bezien foute keuze maakt), kan het inzetten van autonome wapensystemen in strijd met het proportionaliteitsbeginsel zijn.

Op grond van het voorzorgsbeginsel moeten degenen die een aanval plannen of daarover beslissen al het mogelijke doen om de effecten van een aanval op burgers en burgerobjecten te voorkomen, of in ieder geval te minimaliseren. Niet alleen tijdens de uitvoering, maar ook tijdens de planning zullen voortdurend en doorlopend voorzorgsmaatregelen getroffen moeten worden.

In de voorbereidingsfase zullen keuzes over het in te zetten wapen, de tijd en methode van de aanval of het al dan niet opschorten van een aanval, genomen worden. Deze keuzes, die veel redenerend vermogen vereisen, zijn tot op heden aan mensen toebedeeld. Autonome wapensystemen zijn (nog) niet in staat om dergelijke afwegingen te maken.

Ongeacht of de beslissing om over te gaan tot aanval voortkomt uit mens of machine, zal het voorzorgsbeginsel onverkort van kracht blijven: voorzorgsmaatregelen moeten voortdurend en doorlopend genomen worden om effecten van een aanval op burgers en burgerobjecten te voorkomen dan wel te minimaliseren.58

Voor wat betreft de aansprakelijkheid bij inzet van autonome wapensystemen blijft de mens degene die het besluit neemt om een autonoom wapen in te zetten. Aansprakelijkheid kan derhalve altijd teruggevoerd worden naar een menselijke actie, namelijk het besluit tot inzet. De aansprakelijkheid zou wel kunnen verschuiven naar een eerder moment, bijvoorbeeld naar de commandant die over de inzet van de autonome wapensystemen beslist, en mogelijk naar degene die het wapen activeert.

Een zogeheten accountability gap zou slechts kunnen ontstaan bij volledig autonome wapensystemen, waarbij de wapensystemen zich zelfstandig aanpassen aan een dynamische omgeving en doelen aanvallen die niet door de mens vooraf zijn geprogrammeerd of voorzien.59

De hierboven besproken drie beginselen van internationaal humanitair oorlogsrecht en de regels omtrent verboden wapens gelden onverminderd voor (de inzet van) autonome wapensystemen. Onder omstandigheden kunnen autonome wapensystemen en de inzet daarvan verboden zijn onder internationaal humanitair oorlogsrecht, bijvoorbeeld als autonome wapensystemen worden ingezet in een omgeving waar zij niet in staat zijn om onderscheid te maken tussen militaire doelen en burgers en burgerobjecten. Dat neemt niet weg dat (de inzet van) autonome wapensystemen an sich niet verboden is onder internationaal humanitair oorlogsrecht.

Tegelijkertijd dient opgemerkt te worden dat de technologische ontwikkeling van autonome wapensystemen niet stil staat. In de toekomst zullen autonome wapensystemen steeds beter in staat zijn om bepaalde inschattingen en keuzes te maken, geïsoleerd of in samenhang. Hetgeen de machines noch de mensen die de machines inzetten, ontslaat van hun verplichtingen op grond van internationaal humanitair oorlogsrecht.

Het belang van betekenisvolle menselijke controle is dan ook uitermate groot. Neem bijvoorbeeld het proportionaliteitsbeginsel. Autonome wapensystemen zijn vooralsnog niet in staat om de kwalitatieve afweging te maken tussen de verwachte nevenschade en het militaire voordeel. Mochten technologische ontwikkelingen het mogelijk maken dat machines dit wel kunnen, dan is er geen juridisch voorschrift dat stelt dat de kwalitatieve afweging te allen tijde door de mens gemaakt moet worden.

Alhoewel er geen juridisch voorschrift bestaat dat betekenisvolle menselijke controle garandeert, bijvoorbeeld op het gebied van het maken van een kwalitatieve afweging bij het proportionaliteitsbeginsel, stelt het ICRC dat de mens de juridische afwegingen moet maken binnen het oorlogsrecht: «It is the humans subject to IHL who are responsible for applying the law and who can be held accountable for violations, not the weapon itself. The legal requirements under rules governing attacks must be fulfilled by those persons who plan, decide on and carry out attacks, in other words the users of an AWS.»60

Sommigen vinden de discussie over de vraag of autonome wapens ooit zelfstandig het humanitair oorlogsrecht kunnen toepassen speculatief. Vanuit juridisch perspectief zou het niet relevant zijn of een mens, dan wel een machine een doel selecteert en aanvalt; in beide gevallen moet het recht worden nageleefd. Of het nu speculatief is of niet, belangrijker is de vraag of we het acceptabel vinden als juridische beslissingen over het gebruik van geweld door een algoritme worden genomen. De initiatiefneemster is van mening dat op grond van morele verantwoordelijkheid deze beslissing altijd door een mens genomen moet worden. Dat neemt niet weg dat de technologie de mens hierbij kan ondersteunen. Desalniettemin moet de uiteindelijke beslissing en verantwoordelijkheid altijd bij de mens liggen. Het is daarom noodzakelijk dat de inzet van autonome wapensystemen gereguleerd wordt en betekenisvolle menselijke controle gegarandeerd wordt. In lijn hiermee zouden volledig autonome wapensystemen verboden moeten worden wegens het gebrek aan betekenisvolle menselijke controle.

In het bovenstaande zijn autonome wapensystemen, de (inter)nationale ontwikkelingen en de juridische en morele knelpunten daaromtrent aan de orde gesteld. Hieronder volgen de politieke maatregelen die volgens initiatiefneemster genomen moeten worden voor de beheersing van autonome wapensystemen.

Aangezien autonome wapensystemen fundamenteel verschillen van bestaande wapens en unieke uitdagingen oproepen die niet eenduidig in het bestaande oorlogsrecht geadresseerd worden is er een nieuw internationaal verdrag nodig, zoals het Internationale Rode Kruis ook bepleit. Zo staat de noodzaak voor menselijke controle bijvoorbeeld impliciet in het oorlogsrecht, maar is er geen eenduidige interpretatie van het noodzakelijke niveau en de vorm van menselijke controle. Een nieuw verdrag zou dit expliciet moeten maken. Een nieuw verdrag kan de basis leggen voor instrumenten die bij de militaire industrie toezien op mechanismen voor verificatie en compliance, daarnaast kunnen er afspraken gemaakt worden over exportcontrole en autonome systemen die mogelijk een dual-use functie hebben. Wapens als clustermunitie en landmijnen zouden onder het oorlogsrecht ook verboden zijn, omdat ze geen onderscheid maken tussen burgers en strijders. Toch werden ze decennialang massaal gebruikt met veel burgerslachtoffers tot gevolg. Een verbodsverdrag was uiteindelijk nodig om dit expliciet te adresseren en burgerleed te voorkomen.

Een nieuw verdrag over autonome wapens zou betekenisvolle menselijke controle over het gebruik van geweld moeten garanderen. Dus autonome wapens zijn acceptabel zolang ze gebruikt worden met deze menselijke controle. Daarnaast zouden volledig autonome wapens, waarbij betekenisvolle menselijke controle niet mogelijk is, verboden moeten worden. Daarnaast is het internationale aspect hier zo belangrijk, omdat Nederland dit niet alleen kan. Als het kabinet eenzijdige afspraken legt op de nationale industrie kost dit enkel opdrachten, werkgelegenheid en banen in Nederland, terwijl omringende industrieën door het waterbedeffect profiteren van strengere Nederlandse wet- en regelgeving. Daarom is het zo belangrijk om met gelijkgestemde landen aan de bel te trekken en een zo globaal mogelijk verdrag te realiseren.

Een aantal landen lijkt geen behoefte te hebben om een verdrag versneld voor elkaar te krijgen, daardoor is het noodzakelijk om te streven naar duidelijkheid over de samenwerking in bondgenootschappen. Hier kan gekeken worden naar de wijze waarop omgegaan kan worden met landen die bijvoorbeeld clustermunitie gebruiken en geen lid zijn van de Clustermunitie conventie. Nederland mag dan wel blijven samenwerken met landen die zich bijvoorbeeld niet willen aansluiten bij een verdrag over autonome wapensystemen, maar alleen wanneer gedurende een militaire samenwerking geen gebruik gemaakt zal worden van autonome wapensystemen zonder betekenisvolle menselijke controle.

Een groot aantal landen ziet de noodzaak van regulering van autonome wapens, en wil betekenisvolle menselijke controle over deze wapens behouden. Verscheidene Europese staten ondersteunen dit standpunt. De Nederlandse regering moet zich actief inzetten voor een internationaal verdrag dat betekenisvolle menselijke controle over het gebruik van geweld garandeert. In eerste instantie zou dit binnen de UNCCW moeten gebeuren. Wanneer dit het aankomende jaar binnen de UNCCW niet haalbaar blijkt, moet Nederland samen met gelijkgestemde landen het initiatief nemen voor een ander internationaal proces.

Om misverstanden te voorkomen benadrukt de initiatiefneemster ten slotte dat zij het nut en de noodzaak van bepaalde autonome wapensystemen, zoals de Goalkeeper, erkent. Het verdrag is er dan ook niet op gericht om autonome wapensystemen die reeds betekenisvolle menselijke controle kunnen garanderen, te verbieden.

5.1.1. Stel een internationaal verdrag op dat de inzet van autonome wapensystemen reguleert door betekenisvolle menselijke controle te garanderen en volledige autonome wapensystemen verbiedt. Hierbij dient een concrete invulling van het concept betekenisvolle menselijke controle als ijkpunt te worden genomen.

Op dit moment is er maar een zeer beperkt aantal landen dat artikel 36 heeft omgezet in nationale wetgeving. Nederland is een van de weinige die dit wel heeft gedaan. Nederland zou bij andere landen aan moeten dringen om artikel 36 om te zetten in nationale wetgeving.

5.2.1. Roept de Nederlandse regering op om internationaal, vooral binnen de EU, aan te dringen bij andere landen om artikel 36 van het aanvullend Protocol 1 bij de verdragen van de Geneefse conventie 12 augustus 1949 om te zetten in nationale wetgeving.

Technische ontwikkelingen staan niet stil. De afstand van de mens tot het slagveld zal toenemen en nieuwe vraagstukken zullen de kop op steken. Een van die vraagstukken zal zijn hoe om te gaan met human-machine teaming. Bij human-machine teaming gaat het om de samenwerking tussen mens en machine. De vraag die hieruit voortkomt is welke beslissingen altijd door een mens genomen moeten worden De centrale vraag is dus «wat willen we van de mens?» Wat de initiatiefneemster betreft is de mens altijd verantwoordelijk voor het gebruik van geweld. Dus ook bij de inzet van niet-volledige autonome wapensystemen geldt dat een mens uiteindelijk bepaalt het wapen wel of niet in te zetten. Daarnaast dient de mens de controle te behouden over de effecten van een aanval en moeten deze effecten in lijn zijn met zijn of haar intenties.

5.3.1. Kom bij niet-volledige autonome wapensystemen met een expliciete vermelding welke stappen binnen het doelontwikkelingsproces uitgevoerd moeten worden door een mens. Inzet van autonome wapensystemen die daar niet aan voldoen moet niet worden toegestaan.

De industrie houdt zich ook bezig met toekomstige wapensystemen. Daarbij wordt er geïnvesteerd in autonome wapensystemen, AI en robots. De initiatiefneemster is van mening dat de industrie die zich bezighoudt met volledig autonome wapensystemen zonder menselijke controle geen steun mag krijgen Dit betekent geen steun voor de ontwikkeling van volledige autonome wapensystemen met middelen van de Europese Unie, de NAVO of Nederland. Hier ligt ook een taak voor het Europese Defensiefonds, om ervoor te zorgen dat de investeringen in onbemande militaire technologie, zoals bewapende drones, altijd de garantie hebben van betekenisvolle menselijke controle.

5.4.1. Geen investeringen en steun van de Nederlandse regering voor de ontwikkeling van volledig autonome wapensystemen, zowel in Nederland, de Europese Unie (Europees Defensiefonds) als binnen de NAVO. Nederland dient zich actief in te zetten om dit soort investeringen te voorkomen.

Autonome wapens kunnen worden voorzien van een instrument dat data registreert en verzendt naar een database, zodat achteraf onderzoek kan worden gedaan naar de oorzaken van eventueel falen of mogelijke schendingen van het internationaal recht. De initiatiefneemster vindt dat dit bij aankoop en ontwikkeling van autonome wapensystemen onderdeel moet zijn van de vereisten die Nederland stelt. Bij het ontwikkelen van een database is het belangrijk de vraag te stellen wie er toegang tot deze data heeft. Om te voorkomen dat er misbruik van deze data wordt gemaakt dienen hier internationale afspraken over gemaakt te worden.

5.5.1. Zorg dat alle autonome wapensystemen die door Nederland ontwikkeld of aangeschaft worden, worden voorzien van een instrument dat data registreert en verzendt naar een database.

De initiatiefneemster is van mening dat het gebruik van autonome wapensystemen nieuwe risico’s met zich meebrengt die niet onbesproken dienen te blijven. Het kabinet dient deze risico’s voorafgaand aan de besluitvorming van een militaire missie met de Tweede Kamer te bespreken en na afloop van een militaire missie met de Tweede Kamer te evalueren. Het opnemen van het gebruik en de risico’s van autonome wapensystemen in de artikel 100 brief is gezien de complexiteit van deze nieuwe technologie van belang.

5.6.1. Zie het gebruik van niet-volledige autonome wapensystemen bij militaire missies als aandachtspunt bij de artikel 100 procedure.

1. Stel een internationaal verdrag op dat de inzet van autonome wapensystemen reguleert door betekenisvolle menselijke controle te garanderen en volledige autonome wapensystemen verbiedt. Hierbij dient een concrete invulling van het concept betekenisvolle menselijke controle als ijkpunt te worden genomen.

2. Roep de Nederlandse regering op om internationaal, vooral binnen de EU, aan te dringen bij andere landen om artikel 36 van het aanvullend Protocol 1 bij de verdragen van de Geneefse conventie 12 augustus 1949 om te zetten in nationale wetgeving.

3. Kom met een expliciete vermelding welke stappen binnen het doelontwikkelingsproces uitgevoerd moeten worden door een mens. Inzet van wapens die daar niet aan voldoen moet niet worden toegestaan.

4. Geen investeringen en steun van de Nederlandse regering voor de ontwikkeling van volledige autonome wapensystemen, zowel in Nederland, de Europese Unie (Europees Defensiefonds) als binnen de NAVO. Nederland dient zich actief in te zetten om dit soort investeringen te voorkomen.

5. Zorg dat alle autonome wapensystemen die door Nederland ontwikkelt of aangeschaft worden kunnen worden voorzien van een instrument dat data registreert en verzendt naar een database.

6. Zie het gebruik van niet-volledige autonome wapensystemen bij militaire missies als aandachtspunt bij de artikel 100 procedure.

Geen.

Belhaj

Blake Stilwell, «These insane robot machine guns guard the Korean DMZ», Mighty Tactical, We are the Mighty. https://www.wearethemighty.com/gear-tech/robot-machine-guns-guard-dmz?rebelltitem=3#rebelltitem3 (geraadpleegd 2 september 2020).

Karel Berhout, «Aanvaldsdrones zoeken zelf het slachtoffers uit» NRC.nl. 2019. https://www.nrc.nl/nieuws/2019/11/10/aanvalsdrones-zoeken-zelf-het-slachtoffer-uit-a3979795 (geraadpleegd 13 mei 2021).

S/2021/229 - E - S/2021/229 -Desktop (undocs.org): «Logistics convoys and retreating HAF were subsequently hunted down and remotely engaged by the unmanned combat aerial vehicles or the lethal autonomous weapons systems such as the STM Kargu-2 (see annex 30) and other loitering munitions.»

David Hambling, «What Are Drone Swarms And Why Does Everyone Suddenly Want One?» Forbes.com

https://www.forbes.com/sites/davidhambling/2021/03/01/what-are-drone-swarms-and-why-does-everyone-suddenly-want-one/?sh=14a50a3c2f5c (geraadpleegd 13 mei 2021).

«Global Survey Highlights Continued Opposition Fully Autonomous Weapons» Ipsos.com, 2021. https://www.ipsos.com/en-us/global-survey-highlights-continued-opposition-fully-autonomous-weapons (geraadpleegd 13 mei 2021).

Autonome wapensystemen: De Noodzaak van Betekenisvolle Menselijke Controle, No. 97 AIV / No. 26 CAVV, oktober 2016. p. 6.

Frank Slijper, «Slippery Slope: The Arms Industry and Increasingly Autonomous Weapons.» PAXforpeace.nl, 2019 https://www.paxforpeace.nl/publications/all-publications/slippery-slope (geraadpleegd op 31 maart 2021).

De brief van de Minister van Buitenlandse Zaken d.d. 13 mei 2019 inzake internationaal norm kader voor het gebruik van nieuwe technologieën als (onderdeel van) wapensystemen (Kamerstuk 33 694, nr. 45).

Wilmer Heck, «Bedrijven in open brief: stop ontwikkeling «killer robots»» NRC.nl, 20 augustus 2017, https://www.nrc.nl/nieuws/2017/08/20/killer-robots-begin-er-niet-aan-12600687-a1570489 (geraadpleegd 2 september 2020).

Samuel Gibbs, «Elon Musk leads 116 experts calling for outright ban of killer robots» TheGuardian.com, 2017. https://www.theguardian.com/technology/2017/aug/20/elon-musk-killer-robots-experts-outright-ban-lethal-autonomous-weapons-war (geraadpleegd 13 mei 2021).

«An open letter to the United Nations Convention on Certain Conventional Weapons» FutureofLife.org, 2017. https://futureoflife.org/autonomous-weapons-open-letter-2017/#:~:text=An%20Open%20Letter%20to%20the%20United%20Nations%20Convention%20on%20Certain%20Conventional%20Weapons,-As%20companies%20building&text=Lethal%20autonomous%20weapons%20threaten%20to,faster%20than%20humans%20can%20comprehend. (geraadpleegd 13 mei 2021).

United Nations Office of Disarmament. https://www.unog.ch/80256EE600585943/(httpPages)/8FA3C2562A60FF81C1257CE600393DF6?OpenDocument (geraadpleegd 13 mei 2021).

«Protect Civilians: Stop killer robots,» Stopkillerrobots.org, 2020.https://www.stopkillerrobots.org/2020/05/protect-civilians-stop-killer-robots/ (geraadpleegd op 2 september 2020).

Campaign to stop killer robots.org. https://www.stopkillerrobots.org/ (geraadpleegd op 2 september 2020).

«Open brief aan de regering over autonome wapens», Rijksuniversiteit Groningen, 2020. https://www.rug.nl/cf/pdfs/open-brief-aan-de-regering-over-autonome-wapens.pdf (geraadpleegd 13 mei 2021).

ICRC.com, 2021. https://www.icrc.org/en/document/peter-maurer-role-autonomous-weapons-armed-conflict (geraadpleegd 21 mei 2021).

European Parliament Resolution of 12 september 2018 on autonomous weapon systems 2018/2752(RSP), https://www.europarl.europa.eu/doceo/document/TA-8-2018-0341_EN.html (geraadpleegd 2 september 2020).

Regeerakkoord Finland, 2017. https://valtioneuvosto.fi/-/10616/sallistava-ja-osaava-suomi-sosiaalisesti-taloudellisesti-ja-ekologisesti-kestava-yhteiskunta (geraadpleegd 13 mei 2021).

Regeerakkoord België, 2020. https://www.belgium.be/sites/default/files/Regeerakkoord_2020.pdf (geraadpleegd 13 mei 2021).

Regeerakkoord Duitsland, 2018. https://www.tagesschau.de/multimedia/koaltionsvertrag-101~_origin-787f511a-0a95-4a71-81a8-4869d1ec88a4.pdf, nr. 7062–7063 (geraadpleegd op 4 mei 2021).

Autonome wapensystemen: De Noodzaak van Betekenisvolle Menselijke Controle, No. 97 AIV / No. 26 CAVV, oktober 2016. p. 56.

ICRC, Views of the ICRC on autonomous weapon systems, paper submitted to the Convention on Certain Conventional Weapons Meeting of Experts on Lethal Autonomous Weapons Systems (LAWS), 11 april 2016, https://www.icrc.org/en/document/views-icrc-autonomous-weapon-system; ICRC, Autonomous Weapon Systems: Implications of Increasing Autonomy in the Critical Functions of Weapons, ICRC, Geneva, September 2016, https://www.icrc.org/en/publication/4823-autonomous-weapons-systems; ICRC, International Humanitarian Law and the challenges of contemporary armed conflicts. 32nd International Conference of the Red Cross and Red Crescent, oktober 2015, 32IC/15/11, p. 44–47, https://www.icrc.org/en/download/file/15061/32ic-report-on-ihl-and-challenges-of-armed-conflicts.pdf; Neil Davison, «A legal perspective: Autonomous weapon systems under humanitarian law», UNODA Occasional papers: Perspectives on lethal autonomous weapon systems, no. 30, november 2017, p. 5.

NRC; https://www.nrc.nl/nieuws/2019/08/18/die-gamebril-maakt-militairen-dodelijker-a3970441

PAX report: Don’t be evil? https://paxforpeace.nl/media/download/pax-report-killer-robots-dont-be-evil.pdf

rijksoverheid.nl, «Onvoorziene effecten van zelflerende algoritmen.» 2020.,https://www.rijksoverheid.nl/documenten/rapporten/2020/11/20/tk-bijlage-5-bij-kamerbrief-considerati-onderzoek-effecten-algoritmen (geraadpleegd 21 mei 2021).

Communication from the Commission to the European Parliament, the European Council, the Council, the European Economic and Social Committee and the Committee of the Regions on Artificial Intelligence for Europe, Brussel 25 april 2018, COM(2108) 237 final.

Jarno Duursma, «The 12 Risk of Artificial Intelligence», jarnoduursma.nl. https://jarnoduursma.nl/blog/the-risks-of-artificial-intelligence/ (geraadpleegd 21 mei 2021).

Merel Ekelhof. «Lifting the Fog of Targeting: «Autonomous Weapons» and Human Control through the Lens of Military Targeting. Naval War College Review Vol. 17 (3), p. 83.

«Global Survey Highlights Continued Opposition Fully Autonomous Weapons» Ipsos.com, 2021. https://www.ipsos.com/en-us/global-survey-highlights-continued-opposition-fully-autonomous-weapons (geraadpleegd 13 mei 2021).

Boulanin, Davison, Goussac & Carlsson, Limits on autonomy in weapon systems. Identifying Practical Elements of Human Control, SIPRI & ICRC juni 2020 https://www.icrc.org/en/document/limits-autonomous-weapons#:~:text=Limits%20on%20Autonomy%20in%20Weapon%20Systems%3A%20Identifying%20Practical%20Elements%20of,legal%2C%20ethical%20and%20operational%20concerns (geraadpleegd 21 mei 2021).

Amanda Musco Ekmund, «Meaningful Human control of Autonomous Weapon Systems», FOI 2020. http://www.fcas-forum.eu/publications/Meaningful-Human-Control-of-Autonomous-Weapon-Systems-Eklund.pdf (geraadpleegd 13 mei 2021).

Desiree Verweij, «Aan robots heb je niets», Het tijdschrift voor de politie, jg. 71/nr. 7/09, p. 21–22 https://www.politieacademie.nl/kennisenonderzoek/kennis/mediatheek/PDF/74410.pdf (geraadpleegd 13 mei 2021); Desiree Verweij, Geweten onder schot, Boom uitgevers: Amsterdam 2010, hoofdstuk 7.

Eva van Baarle, «Versterken van de morele competentie: Ethiekonderwijs in een militaire context» in: D. Verweij, Ethiek en de militaire praktijk, Boom uitgevers: Amsterdam 2020, p. 40.

«Global Survey Highlights Continued Opposition Fully Autonomous Weapons» Ipsos.com, 2021. https://www.ipsos.com/en-us/global-survey-highlights-continued-opposition-fully-autonomous-weapons (geraadpleegd 13 mei 2021)

Art. 35(2) van het Eerste Aanvullende Protocol bij de Geneefse Verdragen en beschouwd als gewoonterecht.

Art. 51(4)(b) van het Eerste Aanvullende Protocol bij de Geneefse Verdragen en beschouwd als gewoonterecht.

Art. 51(4)(c) van het Eerste Aanvullende Protocol bij de Geneefse Verdragen en beschouwd als gewoonterecht.

Wapensystemen die niet onder deze drie categorieën vallen zijn overigens niet per definitie acceptabel. Het oorlogsrecht stelt dit expliciet aan de orde in de Martens Clausule.

Boulanin, Davison, Goussac & Carlsson, Limits on autonomy in weapon systems. Identifying Practical Elements of Human Control, SIPRI & ICRC juni 2020 (https://www.icrc.org/en/document/limits-autonomous-weapons#:~:text=Limits%20on%20Autonomy%20in%20Weapon%20Systems%3A%20Identifying%20Practical%20Elements%20of,legal%2C%20ethical%20and%20operational%20concerns), p. 4.

Boulanin, Davison, Goussac & Carlsson, Limits on autonomy in weapon systems. Identifying Practical Elements of Human Control, SIPRI & ICRC juni 2020 (https://www.icrc.org/en/document/limits-autonomous-weapons#:~:text=Limits%20on%20Autonomy%20in%20Weapon%20Systems%3A%20Identifying%20Practical%20Elements%20of,legal%2C%20ethical%20and%20operational%20concerns), p. 4.

Kopieer de link naar uw clipboard

https://zoek.officielebekendmakingen.nl/kst-35848-2.html

De hier aangeboden pdf-bestanden van het Staatsblad, Staatscourant, Tractatenblad, provinciaal blad, gemeenteblad, waterschapsblad en blad gemeenschappelijke regeling vormen de formele bekendmakingen in de zin van de Bekendmakingswet en de Rijkswet goedkeuring en bekendmaking verdragen voor zover ze na 1 juli 2009 zijn uitgegeven. Voor pdf-publicaties van vóór deze datum geldt dat alleen de in papieren vorm uitgegeven bladen formele status hebben; de hier aangeboden elektronische versies daarvan worden bij wijze van service aangeboden.