Kamerstuk

| Datum publicatie | Organisatie | Vergaderjaar | Dossier- en ondernummer |

|---|---|---|---|

| Eerste Kamer der Staten-Generaal | 2018-2019 | 34775-VI nr. AH |

Zoals vergunningen, bouwplannen en lokale regelgeving.

Adressen en contactpersonen van overheidsorganisaties.

U bent hier:

| Datum publicatie | Organisatie | Vergaderjaar | Dossier- en ondernummer |

|---|---|---|---|

| Eerste Kamer der Staten-Generaal | 2018-2019 | 34775-VI nr. AH |

Aan de Voorzitter van de Eerste Kamer der Staten-Generaal

Den Haag, 19 december 2018

Inleiding

Tijdens het beleidsdebat met uw Kamer over de Staat van de rechtsstaat op 22 mei 2018, heb ik toegezegd u een brief te sturen met enkele gedachtenlijnen rond de toepassing en het gebruik van algoritmen en artificiële intelligentie (hierna: AI) in het domein van de rechtspleging.1 Met deze brief voldoe ik aan die toezegging.

Er wordt al druk met de nieuwe technologie geëxperimenteerd. Terecht, want zij biedt ons vele aantrekkelijke mogelijkheden. Zij kan dienen ter ondersteuning van het besluitvormingsproces, zij kan onder omstandigheden ook leiden tot het volledig geautomatiseerd nemen van beslissingen. Tegelijkertijd moeten wij de ogen niet sluiten voor mogelijke negatieve effecten van de toepassing ervan. Dat betekent dat wij de mogelijkheden zorgvuldig en behoedzaam moeten verkennen. En tevens dat wij behoefte hebben aan ijkpunten waaraan wij de ontwikkelingen kunnen toetsen. Die ijkpunten liggen besloten in de rechtsstatelijke en democratische waarden die aan ons rechtsbestel ten grondslag liggen.

In deze brief schets ik de mogelijkheden van gebruik van AI en algoritmen in de rechtspleging. Vervolgens benoem ik een aantal ethische vragen die dat oproept en de ijkpunten die ik wil hanteren. Vooraf schets ik de bredere beleidsmatige context en geef ik een aantal actuele voorbeelden van experimenten.

Terreinverkenning

AI refereert aan systemen die intelligent gedrag vertonen door hun omgeving te analyseren en in zekere mate zelfstandig actie te ondernemen om specifieke doelen te bereiken.2 De AI waar het hier om gaat, machine learning, is een techniek om patronen te herkennen in relevante en liefst zo compleet mogelijke databestanden met als doel patronen in de werkelijkheid te ontdekken. Deze kunnen gebruikt kunnen worden bij (1) het detecteren en evalueren van mogelijk relevant bewijsmateriaal, bij (2) het traceren van relevante rechtsbronnen, argumenten en argumentatielijnen in rechtspraak en doctrine, en conflicten tussen toepasselijke regelgeving, en bij (3) het voorspellen van rechterlijke uitspraken.3 Een specifieke vorm van machine learning is deep learning. Dit leunt zwaar op statistisch rekenwerk en neurale netwerken en wordt mede mogelijk door de opkomst van big data. In plaats van te proberen de regels te definiëren die een computer moet gebruiken om bijvoorbeeld taal te «begrijpen», maken computerwetenschappers gebruik van de toenemende hoeveelheden data om software verbanden of regels te laten ontdekken. Via deep learning abstraheren computers informatie op basis van verschillende lagen van neurale netwerken. Nu leren deze modellen nog met behulp van mensen, die bijvoorbeeld aangeven of een beeld een gezicht is of niet, maar er wordt ook gewerkt aan unsupervised learning waarbij de software leert op basis van zelfexploratie en zelfcorrectie.4 Data zijn de brandstof voor AI.5 De ontwikkelingen op dit gebied gaan snel; elk statement daarover is een momentopname. Dat geldt ook voor deze brief.

Als het gaat om de toepassing van AI en algoritmen in de rechtspraak is onder meer het evenwicht in de trias (dat wil zeggen: wetgeving, bestuur, rechtspraak) in geding. De samenleving en het bestuur gaan immers AI volop gebruiken. De rechtspraak kan daarbij niet achter blijven, anders verliest zij aan effectiviteit en legitimiteit. Bovendien komen alternatieve vormen van geschilbeslechting (Alternative Dispute Resolution) buiten de rechtspraak om snel op. Als daarbij intensief gebruik wordt gemaakt van internet en AI, spreken wij van Online Dispute Resolution.6 Ook die ontwikkeling vraagt om een bezinning op wat dit betekent voor de rechtspraak. Het Ministerie van Justitie en Veiligheid is dan ook volop betrokken bij vele initiatieven die op Rijks- en Europees niveau worden ontwikkeld om na te denken over de kansen en mogelijkheden van AI, de grenzen die daaraan gesteld moeten worden en de voorwaarden die daarbij in acht genomen zouden moeten worden. Uitgangspunt is dat technologie ons niet overkomt, maar dat wij zelf bepalen hoe en in hoeverre wij er gebruik van maken.

Overheidsbeleid ten aanzien van de toepassing van AI

Toepassing van AI en algoritmen in de rechtspleging staat niet los van wat er breder binnen de overheid op dit gebied gebeurt. In EU-verband worden normen ontwikkeld voor het gebruik van AI, zoals via de AVG (Algemene verordening gegevensbescherming) en het Statement on Artificial Intelligence, Robotics and «Autonomous» Systems (2018) van de European Group on Ethics in Science and New Technologies. De AVG raakt de toepassing van AI met name waar het gaat om geautomatiseerde individuele besluitvorming. Het Statement is onderdeel van een bredere bezinning binnen de Europese Unie, die tot meer richtinggevende documenten gaat leiden.7 Onlangs heeft de Raad van Europa een European Ethical Charter on the Use of Artificial Intelligence in Judicial Systems and their environment vastgesteld.

Op nationaal niveau is in diverse recente brieven en nota’s melding gemaakt van initiatieven die de rijksoverheid ontplooit. Ik volsta hier met het verwijzen naar die documenten.8 Ik voeg daar voor de goede orde aan toe dat het denken over de toepassing van informatietechnologie in het openbaar bestuur en de rechtspleging niet pas nu is begonnen. Ook in een iets verder verleden zijn daarover al belangrijke documenten gepubliceerd.9 Het kan geen kwaad om, nu de discussie in een stroomversnelling geraakt, dergelijke documenten weer eens onder het stof vandaan te halen.10

Toepassing van AI in relatie tot de rechtspleging

Beslissingen over geschillen komen niet uit de lucht vallen. Er gaat een heel proces aan vooraf van: gegevens (data) verzamelen, relevante feiten selecteren, verzamelde data analyseren, waarderen, interpreteren, duiden. Aan het eind van dit proces c.q. aan de top van de cognitieve piramide staat de uiteindelijke, eigenlijke beslissing. AI en algoritmen kunnen goede diensten bewijzen in de verschillende stadia van de totstandkoming van een beslissing.11 Bovendien kan AI worden ingezet om ondersteunende, administratieve en logistieke processen binnen de betrokken organisaties te versterken. En om burgers te bedienen bij het (laten) beslechten van geschillen op de manier die zij wensen, al dan niet met een beroep op een van overheidswege aangestelde rechter.

Gebruik van AI voor juridische beslissingen

AI kan worden gebruikt om data te verzamelen, te analyseren, of toe te passen, dat wil zeggen: te interveniëren.12 Door de introductie van moderne ICT en het internet komen bijvoorbeeld zulke grote hoeveelheden data aan tekst, beeld en geluid beschikbaar, dat het op niet al te lange termijn voor mensen niet langer mogelijk zal zijn die allemaal nog handmatig te analyseren. Dat geldt bijvoorbeeld ook voor opsporingsambtenaren of rechters. AI kan daarbij prima helpen en is daarvoor misschien zelfs wel noodzakelijk.13 Hetzelfde geldt voor relevante jurisprudentie, wetgeving en literatuur: artificiële intelligentie kan rechters en andere juridische beslissers én ook justitiabelen14 en rechtshulpverleners helpen om snel en trefzeker de weg daarin te vinden. Ze kan trouwens ook de wetgever zelf helpen bij het maken van goede, dat wil zeggen: consistente, toegankelijke en effectieve, wetgeving.15

Gebruik van AI voor andere, niet-inhoudelijke doeleinden

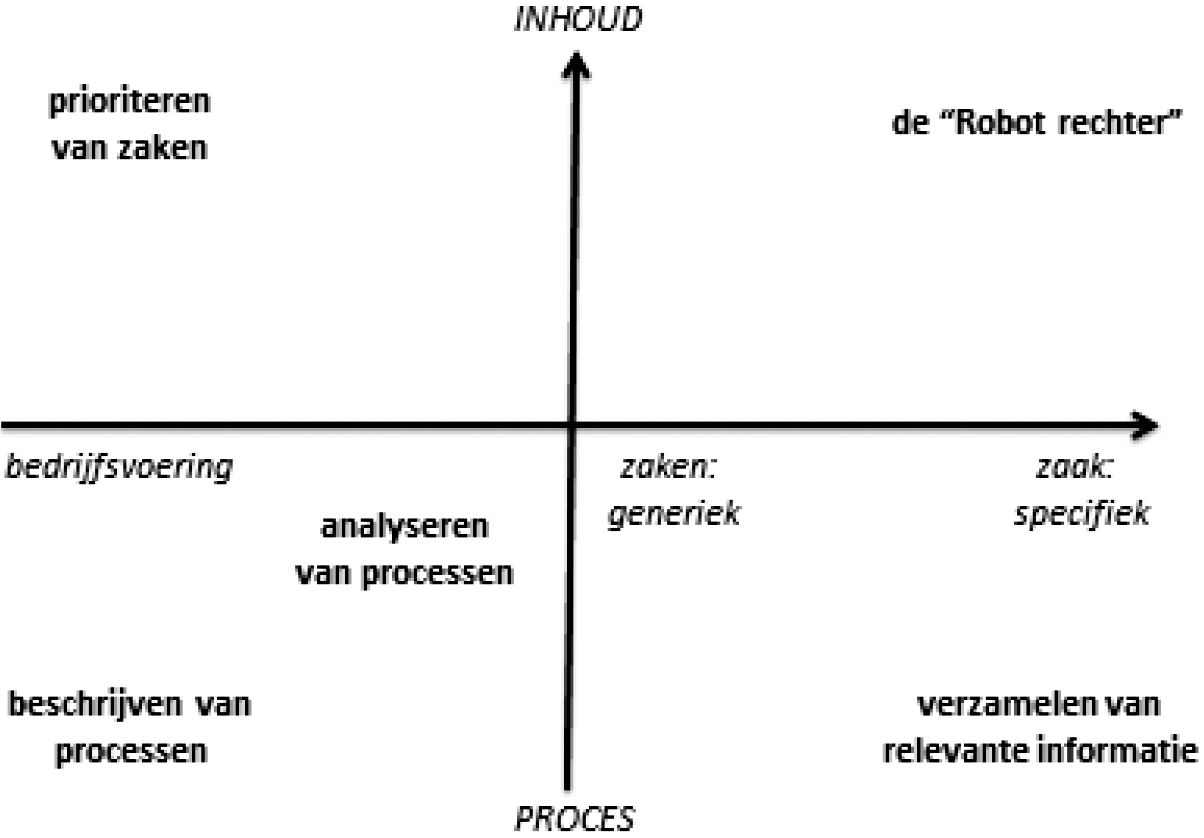

Naast het eigenlijke inhoudelijke beslissingsproces zijn er nog andere toepassingen van AI en algoritmen in de sfeer van de rechtspleging denkbaar. Deels zijn die ook al gerealiseerd of in ontwikkeling. Deze hebben betrekking op andere aspecten dan de inhoudelijke beslissing over een geschil. Te denken valt aan de bedrijfsvoering, de prioritering van zaken, het voorbereiden van zaken, het organiseren van tegenspraak. Ook bij die andere toepassingsmogelijkheden doen zich vragen en dilemma’s voor, onder meer op het punt van de transparantie – een van de kernwaarden van de rechtspraak.16

De verschillende toepassingsmogelijkheden kunnen als volgt schematisch worden weergegeven:

Tot dusver ging het alleen nog over de mogelijkheden die toepassing van AI en algoritmen biedt voor de overheid. Maar nieuwe technologie biedt ook belangrijke nieuwe mogelijkheden aan de rechtzoekende burger. Ik noemde al de mogelijkheden van Online Dispute Resolution. Daarnaast kan de technologie helpen om veel meer, sneller en betrouwbaarder inzicht te krijgen in de kansen op succes in een rechtszaak, of om de strategie in een geding te bepalen.

Experimenten met de toepassing van AI

Deze brief richt zich op de rechtspleging in ruime zin: het geven van meer of minder bindende beslissingen over rechten en verplichtingen van mensen in concrete geschillen. In de klassieke rechtspraak betreft dat rechtspraak door professionele, door de staat speciaal voor die taak aangestelde rechters. Daarnaast zijn er allerlei vormen van buitengerechtelijke geschilbeslechting, waarin eveneens rechten en plichten van burgers meer of minder bindend worden toegedeeld: arbitrage, bindend advies, Online Dispute Resolution. Op dit gebied wordt al druk geëxperimenteerd met het gebruik van AI ter voorbereiding van de beslissing.

Zo is bij de Rechtbank Oost-Brabant een project gestart onder de naam Kunstmatige Intelligentie Kennissysteem voor de rechtspraak. De kernvraag van dit experiment is: «Wat zijn de mogelijke toepassingen van een AI-kennissysteem bij het analyseren, voorbereiden en nemen van beslissingen door de rechter?» Dit project gaat verder dan enkel een traditioneel experiment. Het wil niet alleen deze vragen op basis van theoretische inzichten beantwoorden, maar ontwikkelt ook een kunstmatig intelligent kennisondersteunend systeem en gaat daarmee experimenteren. Het experiment is zo een combinatie van denken en doen. Dit kennissysteem analyseert de ingevoerde data/processtukken zelf, zoekt aan de hand van teksten (de processtukken) op vergelijkbare rechtszaken en geeft de gebruiker de top-10 van meest vergelijkbare rechtszaken. Het verzamelt de feiten en zoekt op basis daarvan naar matching met andere rechtszaken. Dit gebeurt in eerste instantie bij relatief simpele «bulk»-zaken, in het bijzonder Mulder-zaken (lichte verkeersovertredingen). Doel is te kijken of deze specifieke AI-functionaliteit de kwaliteit van de rechtspraak kan verbeteren, hoe de actoren in de rechtspraak daarmee om kunnen gaan en welke impact deze technologie heeft op de rechtspraak.

In een samenwerkingsverband van OM, DJI en CJIB is het project Softwarematige collega-robots gestart. Dit richt zich op het verkrijgen van informatie voor voorwaardelijke invrijheidstelling (VI). Het gaat daarbij om de gegevens die nodig zijn om de juiste voorwaarden aan VI te kunnen stellen en om informatie voor slachtoffers van het delict en/of nabestaanden van overleden slachtoffers. Het stellen van bijzondere voorwaarden voor de VI is een taak van het OM. Softwarematige robots (Robot Process Automation) worden ingezet om de kwaliteit van het proces sprongsgewijs te verbeteren en de informatievoorziening zowel extern, dus bijvoorbeeld naar slachtoffers, als binnen de keten snel en innovatief te verbeteren.

Het OM voert een experiment uit om met AI jurisprudentie te analyseren met als doel een officier voor te bereiden op een zaak of zitting (project Jurisprudentierobot). AI zou het OM en de keten als geheel in staat kunnen stellen sneller, efficiënter en ook meer andersoortige relevante informatie uit de jurisprudentie te halen. Er wordt gebruik gemaakt van AI die kan «leren», zodat de resultaten steeds «slimmer» worden. Het streven is om een custom-made tool te bouwen, die de researchtijd van de professional binnen het OM kan beperken en die betrokkene kan helpen zich kwalitatief beter voor te bereiden op een zaak of zitting. Dat moet leiden tot verhoging van de productiviteit en van de kwaliteit van beslissingen.

De IND voert een project uit op het gebied van beeldherkenning. Dit betreft het herkennen van stempels en handtekeningen op buitenlandse brondocumenten, zoals geboortebewijzen of huwelijksakten. Het systeem moet een waarschijnlijkheidsoordeel geven over de echtheid van deze documenten. Momenteel worden jaarlijks ongeveer 50.000 brondocumenten handmatig op echtheid onderzocht. Dit is tijdrovend. In dit project worden technieken voor beeldanalyse ontwikkeld en ingezet bij het valideren van documenten, waarbij AI echt en niet-echt schift. Hierdoor wordt het onderzoeksproces substantieel versneld en de effectiviteit en efficiëntie ervan verhoogd. Uniek hierbij is de triple helix samenwerking tussen IND, TNO en een bedrijf voor het ontwikkelen, produceren en uitgeven van software.

De vier genoemde projecten worden gefinancierd door het Innovatieteam van het Ministerie van Justitie en Veiligheid en de bij het project betrokken organisaties samen.

Daarnaast wijs ik op de activiteiten in het kader van het LivingLab van het Ministerie van Justitie en Veiligheid. Een van die projecten is bijvoorbeeld om te onderzoeken of via tekstuele analyse van talrijke dossiers van de Kinderbescherming achteraf kan worden vastgesteld dat er in die zaken aanwijzingen van kindermishandeling of -misbruik waren. Het ligt voor de hand om op dezelfde wijze beslissingen van bestuur of rechter achteraf te verifiëren met AI om te bezien wat dat oplevert en wat wij daaruit leren.

Een ander experiment in het kader van het LivingLab is het project Beter inzicht burgers met schulden, dat samen met het CJIB zal worden uitgevoerd. Hiermee wordt gezocht naar patronen in schuldproblematiek. Als deze kunnen worden gesignaleerd, kan worden overwogen om door vroegtijdige interventies deze mensen zodanig te ondersteunen dat zij niet in de problemen komen.

Binnen het Ministerie van Justitie en Veiligheid is voorts een AI Circuit actief. Dat is een community waarin kennis en ervaringen over en met AI worden uitgewisseld. Ook worden lezingen en seminars georganiseerd voor ambtenaren en bestuurders over de kansen en risico’s en over de ethische, juridische en maatschappelijke effecten van AI. Ik wil dit AI Circuit uitbouwen tot een platform waar projecten en pilots op het gebied van de toepassing van AI in het domein van Justitie en Veiligheid worden aangemeld en geëvalueerd. Voor alle projecten en applicaties geldt dat de ethische discussie al vooraf en gedurende het project moet worden gevoerd, niet pas als het project (bijna) klaar is of de applicatie (bijna) in gebruik wordt genomen.

IJkpunten bij de toepassing van AI in de rechtspleging

Centraal in deze brief staat de vraag of er ijkpunten kunnen worden gevonden waaraan de ontwikkelingen kunnen worden getoetst. Daarvoor neem ik artikel 17 van de Grondwet («Niemand kan tegen zijn wil worden afgehouden van de rechter die de wet hem toekent»), artikel 6 van het Europees Verdrag voor de Rechten van de Mens en de Fundamentele Vrijheden (EVRM) en artikel 47 van het Handvest van de grondrechten van de Europese Unie als uitgangspunt. Uit artikel 6 EVRM en artikel 47 Handvest vloeien vijf beginselen van behoorlijke rechtspleging voort: toegankelijkheid van de rechtspleging, interne en externe openbaarheid, snelheid («berechting binnen redelijke termijn»), onafhankelijkheid en onpartijdigheid van de rechter, en eerlijkheid van het proces (fair trial). Die beginselen zijn de uitdrukking van rechtsstatelijke en maatschappelijke waarden. Sommige van die beginselen kunnen door de toepassing van AI onder druk komen te staan. Het kan zijn dat zij een andere vorm of invulling zullen (moeten) krijgen, maar de waarden waaraan zij uitdrukking geven, willen wij behouden. Daarom zijn dit de ijkpunten waaraan de toepassing van AI kan en moet worden getoetst.

Als het gaat om inhoudelijke beslissingen over geschillen kunnen wij kijken naar de wijze van waarheidsvinding, naar de selectie en waardering van de feiten en argumenten waarop de beslissing wordt gebaseerd, naar de redeneerpatronen en naar de verantwoording. Het ligt enigszins voor de hand dat gebruik van algoritmen beter past bij wat in het bestuursrecht heet «gebonden beschikkingen» dan bij beslissingen die veel beoordelings- en/of beslisruimte kennen.17 Dat neemt niet weg dat zich in alle gevallen ethische vragen kunnen aandienen die zorgvuldige afweging en toetsing vereisen.

Openbaarheid / inzichtelijkheid bij de feitenvaststelling

In het procesrecht is het onderscheid tussen de feiten en het recht fundamenteel. De rechter is vrij in de manier waarop hij kennis krijgt van het toepasselijke recht. Daar kan toepassing van technische hulpmiddelen, zoals AI of data-analyse, nauwelijks op bezwaren stuiten. De rechter is immers vrij – en ook verplicht – om ambtshalve de rechtsgronden aan te vullen (artikel 25 Wetboek van Burgerlijke Rechtsvordering; en in het bestuurs- en het strafprocesrecht is dat niet anders). Maar als het gaat om de vaststelling van de relevante feiten, is de rechter op de verschillende rechtsgebieden gebonden aan verschillende regels en beperkingen. In civielrechtelijke verhoudingen zijn partijen vrij hun geschil aan anderen dan de rechter voor te leggen en eventueel ook afstand te doen van hun wettelijke rechten (artikel 6 EVRM, artikel 17 Grondwet, hiervóór genoemd), maar alleen op basis van vrijwillige instemming. In die civielrechtelijke context bepalen partijen in beginsel ook zelf de omvang van het geding: de rechter mag, afgezien van enkele in de wet gespecificeerde uitzonderingen, «slechts die feiten of rechten aan zijn beslissing ten grondslag leggen, die in het geding aan hem ter kennis zijn gekomen of zijn gesteld (…) Feiten of rechten die door de ene partij zijn gesteld en door de wederpartij niet of niet voldoende zijn betwist, moet de rechter als vaststaand beschouwen (…)» (artikel 149, eerste lid, Wetboek van Burgerlijke Rechtsvordering). In strafzaken mag, om een ander voorbeeld te noemen, de strafrechter niet onbeperkt gebruik maken van informatie die hij op internet vindt: niet alles wat daar te vinden is, kan worden aangemerkt als «feiten van algemene bekendheid» (artikel 339, tweede lid, Wetboek van Strafvordering).18 Deze regels zijn de uitdrukking van belangrijke rechtsstatelijke beginselen, zoals de interne en externe openbaarheid van de rechtspraak. Die willen wij ook in het tijdperk van AI en algoritmen overeind houden.19 Deze beginselen dienen dus als ijkpunt bij de toetsing van ontwikkelingen, hoewel de wijze waarop een en ander wordt ingevuld in de toekomst misschien wel kan veranderen.

Rechtsvinding, rechtsvorming en de waarde van debat en tegenspraak

Daarbij moet bedacht worden dat de rechtspraak in feitelijke aanleg, dat wil zeggen: bij de kantongerechten, de rechtbanken en de gerechtshoven, voor een groot deel bestaat uit vaststelling van feiten. In die feiten ligt het recht besloten. Of, nauwkeuriger gezegd: recht en feit zijn op elkaar betrokken. Welke rechtsregels toepasselijk zijn, wordt mede bepaald aan de hand van de relevante feiten; en wat de relevante feiten zijn, wordt mede bepaald aan de hand van de toepasselijke rechtsregels.20 Rechtstoepassing is iets anders dan de mechanische toepassing van rekenregels op een dataset; het is de vaststelling, selectie en waardering van feiten die relevant zijn voor de beslissing vanuit een ongedefinieerde hoeveelheid ambigue data én het vellen van een moreel oordeel op basis van en óver die feiten. Daar komt bij dat veel begrippen en regels voor verschillende interpretatie vatbaar zijn. Dat maakt dat er in veel gevallen niet één juiste «oplossing» is van een juridisch vraagstuk of een casus. Hieraan ontleent het juridische debat, hetzij in de rechtszaal of in de raadkamer of in de wetenschap, zijn zin. En hetzelfde geldt voor het hoger beroep als instituut c.q. het beginsel van rechtspraak in twee feitelijke instanties. In dit debat wordt recht niet enkel gevonden, maar ook gevormd. Het louter voorspellen van rechterlijke uitspraken op basis van bestaande rechtsbronnen is dus nog geen garantie voor goed, rechtvaardig recht. Het debat is een waarde op zich, die wij niet ongemerkt overboord moeten laten glijden door de toepassing van AI en algoritmen. Ook dit is dus een ijkpunt: in hoeverre laat de introductie van AI ruimte voor het juridisch debat, met name in de rechtszaal.

Motivering en verantwoording van beslissingen

Hoe AI-systemen tot hun uitkomsten komen, onttrekt zich gemakkelijk aan onze waarneming.21 Dat is bij rechters «van vlees en bloed» niet anders. Wat zich in het hoofd en het gemoed van de rechter en wat zich bij de beraadslagingen in de raadkamer afspeelt, weten wij niet. Om dat gemis te compenseren, eisen wij van rechters dat zij hun beslissingen motiveren, dat wil zeggen van een deugdelijke (toereikende, overtuigende) motivering voorzien. Die eis hebben wij zelfs in de Grondwet vastgelegd (artikel 121 Grondwet: «Vonnissen moeten de gronden inhouden waarop zij rusten») en in de diverse wetboeken en wetten voor het burgerlijk, het administratief en het strafprocesrecht herhaald. Deze eis drukt fundamentele rechtsstatelijke waarden uit en blijft daarom onverkort van toepassing ook bij het gebruik van AI in de rechtspleging. Dat levert nu al spanningen op. Het ijkpunt is hier de mate waarin de beslissing, ook als die tot stand is gekomen met toepassing van AI, nog steeds de gronden inhoudt waarop zij berust. Die motivering kan niet zijn dat de beslissing nu eenmaal de onvermijdelijke uitkomst is van een statistische analyse van de jurisprudentie tot op dat moment. Want daarmee blijft de vraag onbeantwoord waarom die analyse ook in dít geval de uitkomst zou móeten dicteren. En de motivering wordt urgenter naarmate de data-gestuurde algoritmen complexer worden en daarmee hun werking ondoorzichtiger wordt.22

Transparantie

De ruimte voor het gebruik van AI en algoritmen in de rechtspleging wordt mede bepaald door de AVG (EU Verordening 2016/679: artikel 22) en de Richtlijn gegevensbescherming strafrecht (EU Richtlijn 2016/680: artikel 11). De beperking geldt met name geautomatiseerde individuele besluitvorming, waaronder profiling. Het is bekend dat bijvoorbeeld profilering kan leiden tot bias, d.w.z. ingebouwde, verborgen vooroordelen. Daarnaast is bekend dat de hogere vormen van AI (deep learning: zelflerende systemen) redeneerpatronen ontwikkelen die wij mensen niet meer kunnen doorgronden.23 Onder geautomatiseerde individuele besluitvorming valt potentieel ook geautomatiseerde geschilbeslechting. De meningen zijn verdeeld over de vraag of het ooit technisch mogelijk is dat computers – dat wil zeggen: software, systemen, «robots» – recht gaan spreken.24 Als dat al het geval zou zijn, blijft de vraag in hoeverre en onder welke condities wij ook wíllen dat dat gebeurt. De AVG en de Richtlijn gegevensbescherming strafrecht stellen daar beperkingen aan. Nu kan de justitiabele tegen een besluit van een bestuursorgaan of tegen de uitspraak van een private geschillencommissie nog in beroep gaan bij de rechter.25 Maar de rechter heeft in concrete geschillen het laatste woord: tegen een onherroepelijke uitspraak van een rechter is geen beroep meer mogelijk. Dat geeft een extra gewicht aan de afwegingen rond toepassing van AI door de rechter. Tegelijk moet worden vastgesteld dat bestuursorganen hun werk altijd doen «in de schaduw van de rechter»: wat een bestuursorgaan besluit of doet, kan in principe altijd door de justitiabele aan een rechter ter toetsing worden voorgelegd. Zie bijvoorbeeld de casus die aan de orde is in de uitspraak van de Afdeling Bestuursrechtspraak van de Raad van State van 17 mei 2017, waarin de Afdeling eisen stelt aan de inzichtelijkheid van gegevens en berekeningen die aan een besluit van een bestuursorgaan ten grondslag worden gelegd.26 De besluitvorming door het bestuursorgaan, al dan niet met gebruikmaking van AI, moet dus altijd een rechterlijke toets kunnen doorstaan, ook al wordt er in veel gevallen geen beroep ingesteld. En dat geldt eens te meer voor het openbaar ministerie bij het afdoen van strafzaken via strafbeschikkingen, of bij het behandelen van bezwaar in Mulder-zaken. In mijn brief van 9 oktober jl. aan de Tweede Kamer ben ik nader ingegaan op de eis van transparantie in relatie tot het gebruik van algoritmes door de overheid.27

Toegankelijkheid: bejegening van de justitiabele

Een eigenstandige waarde van berechting door menselijke in plaats van «geautomatiseerde» rechters is dat rechtzoekenden gehoord willen worden. De acceptatie van beslissingen van rechters en bestuursorganen berust minstens zo sterk op de manier waarop de rechtzoekende wordt behandeld als op de materiële uitkomst van die behandeling, dat wil zeggen: of de justitiabele gelijk krijgt of niet. Dit pleegt te worden aangeduid als het belang van procedurele rechtvaardigheid.28 Verwant hiermee is, in ieder geval in strafzaken, het morele element dat aan straf eigen is en behoort te zijn: straf beoogt mensen ter verantwoording te roepen voor hun daden.29 Wij hebben er nog nauwelijks ervaring mee wat de digitalisering op dit punt gaat betekenen. Maar zulke waarden mogen niet achter de horizon verdwijnen. Zij horen bij de «menselijke maat» die wij in het openbaar bestuur en de rechtspleging in acht moeten nemen. Een ander aspect van die «menselijke maat» is de noodzaak van maatwerk in de moeilijkere gevallen. Denk aan de persoonsgerichte aanpak, die de afgelopen decennia tot ontwikkeling is gekomen in de strafrechtspleging. Wij zullen de komende tijd moeten verkennen of – en zo ja hoe – inzet van AI kan bijdragen aan een dergelijke aanpak. De mate van acceptatie door de justitiabelen van beslissingen die met toepassing van AI en algoritmen tot stand komen, is dus een belangrijk ijkpunt bij het beoordelen van nieuwe toepassingen op dit gebied.

Open data, open overheid, open rechtspraak

Binnen de commerciële advocatuur worden inmiddels al applicaties van buitenlandse aanbieders in licentie afgenomen. Deze applicaties helpen om allerhande data die door de Rechtspraak worden gegenereerd, te analyseren. Ook valt voor te stellen dat er commerciële, op AI gebaseerde applicaties voor online dispute resolution komen van buitenlandse aanbieders. Wat de impact hiervan kan en zal zijn op het functioneren van de Nederlandse klassieke beroepsgroepen, is nog moeilijk te overzien. Het lijkt niet te gewaagd om te stellen dat die impact groot kan zijn. Vertrouwde manieren van werken, vertrouwde spelers en vertrouwde posities lijken niet per se ook voor de toekomst gegeven. Maar dat mag er niet toe leiden dat essentiële waarden – als zorgvuldigheid, kwaliteit, toegankelijkheid en rechtsgelijkheid – in de knel komen.

Toepassing van zulke applicaties leidt ook tot vragen over welke informatie de overheid respectievelijk de Rechtspraak wel en niet openbaar beschikbaar moet stellen. Openheid stuit mogelijkerwijs op grenzen van privacy. Die moeten bewaakt worden – en het valt niet uit te sluiten dat dat tot lastige keuzes kan leiden.

Handelingsperspectief

Dit alles laat duidelijk genoeg zien dat wij behoedzaam te werk moeten gaan. Wij moeten gaan experimenteren met de nieuwe technologie buiten de context van reële, aanhangige rechtszaken of geschillen.30 En die experimenten moeten worden uitgevoerd in kleine, overzichtelijke en beheersbare stappen. Deze opvatting werd ook algemeen gedeeld in een expert meeting die ter voorbereiding van deze brief is gehouden op 4 juli jongstleden, waar een keur van deskundigen op dit gebied aanwezig was, en in gesprekken met deskundigen die nadien zijn gevoerd.31 In ieder project zal: (1) vooraf moeten worden bepaald welk probleem moet worden «opgelost» met de nieuwe technologie en wat de criteria zijn voor succes of falen, mede aan de hand van de in deze brief genoemde ijkpunten, (2) moeten worden afgebakend welke problemen níet worden opgelost, en (3) achteraf ook moeten worden bezien welke nieuwe problemen eventueel veroorzaakt of te verwachten zijn door de toepassing van de nieuwe technologie.32 Daarbij is het uitgangspunt vooralsnog niet: keus tussen mens óf machine, maar: keuze voor mens én machine, die «samenwerken» als «team» (AI als augmented intelligence). Want voorshands lijkt dat de sterkste combinatie.33 Bij experimenten geldt voorts dat «succes» ook kan inhouden dat de conclusie wordt getrokken dat een bepaalde toepassing níet mogelijk of wenselijk is.

Eerder in deze brief noemde ik een aantal experimenten met de toepassing van AI. Op die weg zullen wij voortgaan. Sommige van de daar genoemde experimenten lopen door in 2019. Daarnaast zal het Innovatieteam van het Ministerie van Justitie en Veiligheid in 2019 een aantal projecten uitvoeren op het terrein van de rechtspleging. De experimenten zullen onder andere moeten leiden tot concretiseringen van de ijkpunten die ik in deze brief – zonder pretentie van volledigheid – noemde. Tevens zal moeten blijken of nadere regelgeving of kaderstelling wenselijk en mogelijk is. Daarnaast is vanuit de advocatuur de wens uitgesproken om te komen tot een systeem van certificering van AI-toepassingen op het brede terrein van de rechtspleging, waarbij de certificerende instanties worden geaccrediteerd door een orgaan op het niveau van de Europese Unie. Ik vind dat een interessante gedachte, die ik nader wil verkennen. Vragen die zich aandienen betreffen onder meer de behoefte, de belangen die ermee gemoeid zijn, de politieke haalbaarheid en de praktische realiseerbaarheid en inrichting van een dergelijk systeem.

Bij het ontwerpen van AI-applicaties moeten allerlei ontwerpbeslissingen worden genomen. Daarvoor moeten IT-experts samenwerken met domeinexperts: juristen, maar ook andere disciplines.34 De IT-experts moeten zich verdiepen in de juridische kant van de zaak, de juristen moeten vooral kennis opdoen van statistiek; want dat is tenslotte de kern van AI. Dat moet hen helpen begrijpen hoe statistiek werkt, wat zij wel en niet kan, hoe je de betekenis en kwaliteit van datasets kunt bepalen, hoe bias kan insluipen in datasets en in rekenregels (bewerkingen, algoritmen), hoe je correlatie kunt onderscheiden van causaliteit, wat false positives en false negatives inhouden, enzovoort, en hoe zij vanuit die andere disciplines de vertaalslag kunnen maken naar het juridische en normatieve denken.

De ontwikkelingen op het terrein van AI en recht gaan snel. Op vele fronten wordt al actie ondernomen en geëxperimenteerd. Ik volg de ontwikkelingen nauwlettend om de hiervoor beschreven ijkpunten te bewaken en om te bezien of er bijvoorbeeld nieuwe regelgeving of nieuw beleid nodig is. Op dit moment zie ik nog geen punten die direct nieuwe regelgeving of beleid eisen, los van wat al in het wetgevingsprogramma van het departement is opgenomen.

De Minister voor Rechtsbescherming, S. Dekker

Kamerstukken II, 2017–2018, 22 112, nr. 2578, p. 2 (brief van de Minister van Buitenlandse Zaken van 1 juni 2018: Fiche: Mededeling Kunstmatige intelligentie voor Europa).

Prof. Mireille Hildebrandt: position paper voor rondetafelgesprek over «AI in het recht» in de Tweede Kamer, 29 maart 2018.

Rathenau Instituut: Opwaarderen. Borgen van publieke waarden in de digitale samenleving (2017), p. 42.

European Group on Ethics in Science and New Technologies: Statement on Artificial Intelligence, Robotics and «Autonomous» Systems (9 maart 2018), p. 7.

Bastiaan van Zelst: The End of Justice(s)? Perspectives and Thoughts on (Regulating) Automation in Dispute Resolution (oratie 2018), p. 9.

Zo heb ik in mijn brief van 9 juli uw Kamer geïnformeerd over wat er nationaal en in Europees verband aan trajecten loopt die (mede) betrekking hebben op de vraag naar nadere normering van het proces van digitale transformatie (Kamerstukken I, 2017–2018, 34 775 VI, AB). In die brief maakte ik onder andere melding van de oprichting van een interdepartementale beleidsgroep die de beleidsvisie van het kabinet op de impact van AI op de publieke waarden en mensenrechten nader zal uitwerken, evenals een onderzoek naar de juridische aspecten van algoritmen die zelfstandig besluiten nemen, een onderzoek naar het gebruik van AI in het onderwijs, een onderzoek naar desinformatie en een proeftuin voor behoorlijk datagebruik. Bij brief van 15 juni 2018 van mijn ambtgenoten van EZK, BZK en JenV is de Tweede Kamer geïnformeerd over de Digitaliseringsstrategie van dit kabinet (Kamerstukken II, 2017–2018, 26 643, nr. 541). Bij brief van 16 april heb ik de Tweede Kamer geïnformeerd over enkele initiatieven met betrekking tot digitale alternatieve geschilbeslechting (Kamerstukken II, 2017–2018, 29 279, nr. 423; alsook de antwoorden op enkele sets Kamervragen over dit onderwerp, de Tweede Kamer aangeboden op 18 april). In mijn brief van 9 oktober jl. heb ik de Tweede Kamer geïnformeerd over mijn visie op het thema transparantie in relatie tot het gebruik van algoritmen door de overheid (Kamerstukken II, 2018–2019, 26 643, nr. 570). En in onze brief van 29 juni hebben mijn ambtgenoot van Justitie en Veiligheid en ik de Tweede Kamer geïnformeerd over de ambities van de strafrechtsketen, waaronder begrepen de ambities ten aanzien van de digitalisering van de keten. Een deel van de in het Regeerakkoord daarvoor bestemde gelden zal ook worden ingezet voor innovatie; plannen daarvoor worden nu gemaakt (Kamerstukken II, 2017–2018, 29 279, nr. 449).

Zie onder meer de nota Wetgeving voor de elektronische snelweg (Kamerstukken II, 1997–1998, 25 880, nrs. 1–2) en de rapporten van de WRR: Staat zonder land. Een verkenning van bestuurlijke gevolgen van informatie- en communicatietechnologie (1998) en De toekomst van de nationale rechtsstaat (2002); het rapport van Ronald van den Hoogen: Beginselen van digitalisering van rechtspraak (2008), opgesteld in opdracht van de Rechtspraak. En niet te vergeten het klassieke preadvies voor de VAR van prof. Franken uit 1993: Kanttekeningen bij het automatiseren van beschikkingen.

Prof. Corien Prins, voorzitter van de WRR, wees hierop in het rondetafelgesprek in de Tweede Kamer op 29 maart 2018 over «AI in het recht».

Zie bijv. het artikel van B.J. van Ettekoven, voorzitter van de afdeling Bestuursrechtspraak van de Raad van State: Behoorlijke bestuursrechtspraak in het Big data tijdperk. In: R.J.N. Schlössels e.a. (red.): In het nu.... Over toekomstig bestuursrecht (2018), p. 209–233.

Rathenau Instituut: Opwaarderen. Borgen van publieke waarden in de digitale samenleving (2017), p. 44, 127–129.

Vgl. WRR: Big data in een vrije en veilige samenleving (2016) en het kabinetsstandpunt daarover (Kamerstukken II, 2016–2017, 26 643, nr. 426).

Onder «justitiabele» versta ik degene die is onderworpen aan een besluit van een overheidsorgaan en/of die zich tot een rechterlijke instantie wendt voor de oplossing van een geschil.

Zo onder meer Bart Custers & Frans Leeuw: Legal big data. Toepassingen voor de rechtspraktijk en juridisch onderzoek. NJB 2017, p. 2449–2456; Frans L. Leeuw: Wetgeving, empirisch-juridisch onderzoek en Legal Big Data. Recht der Werkelijkheid 2015, p. 50–65.

Corien Prins & Jurgen van der Roest: AI en de rechtspraak. Meer dan alleen de «robotrechter», NJB 2018, p. 260–268.

Vgl. Roeland Stolk, Jeroen Boot en Harro Spanninga: De data beslissen? Een kwestie van waarden! (26 november 2018; https://www.montesquieu-instituut.nl/9353000/1/j9vvj72dlowskug/vktmel60gzst?pk_campaign=hofv-1811&pk_kwd=vktmel60gzst).

Bijv. HR 29 maart 2016, NJ 2016, 249 («De enkele grond dat gegevens aan internetbronnen zijn ontleend, maakt deze feiten daarom nog niet feiten van algemene bekendheid. Feiten van algemene bekendheid zijn in de regel gegevens die geen specialistische kennis veronderstellen en waarvan de juistheid redelijkerwijs niet voor betwisting vatbaar is.»).

Voor de verhouding tussen digitalisering en kernwaarden van het strafrecht meer in het bijzonder verwijs ik naar het rapport Beginselen digitaal (2016) van enkele onderzoekers van de Open Universiteit, aangeboden aan de Tweede Kamer bij brief van de Minister van Veiligheid en Justitie van 13 juni 2017, Kamerstukken II, 2016–2017, 29 279, nr. 388.

Asser-Scholten: Algemeen Deel, par. 26 (1974) (https://dare.uva.nl/search?identifier=2ba44453-5d42-4fea-885c-56d7632a10db).

«AI’s inner workings can be extremely hard – if not impossible – to track, explain and critically evaluate» (European Group on Ethics in Science and New Technologies: Statement on Artificial Intelligence, Robotics and «Autonomous» Systems, 2018, p. 7).

Cf. Bastiaan van Zelst: The End of Justice(s)? Perspectives and Thoughts on (Regulating) Automation in Dispute Resolution (oratie 2018), p. 26–27.

«Deep learning and so-called «generative adversarial network approaches» enable machines to «teach» themselves new strategies and look for new evidence to analyse. In this sense, their actions are often no longer intelligible, and no longer open to scrutiny by humans» (European Group on Ethics in Science and New Technologies: Statement on Artificial Intelligence, Robotics and «Autonomous» Systems, 2018, p. 6).

Vgl. onder meer (in geheel verschillende zin): Jaap van den Herik: Kunnen computers rechtspreken? (1991); Henry Prakken: Komt de robotrechter er aan? NJB 2018, p. 269–274.

Bij «ketenbesluiten», d.w.z.: besluiten die bestuursorganen nemen op basis van gegevens die zij hebben verkregen van andere bestuursorganen, rijst de dubbele moeilijkheid dat gegevens en algoritmen die ten grondslag lagen aan een bepaald besluit mede bepalend (kunnen) zijn voor een ander besluit, door een ander bestuursorgaan in een andere juridische context genomen; en dat een gegrond bezwaar of beroep tegen het ene besluit niet betekent dat het andere besluit ook wordt aangepast (Corien Prins: Bestuursrecht & digitalisering. NJB 2018, p. 539).

Zie bijvoorbeeld Raad voor het openbaar bestuur: Hoe hoort het eigenlijk? Passend contact tussen overheid en burger (juni 2014), p. 8, 16.

Het Rathenau Instituut wijst – zij het in iets ander verband – op «het risico van een zekere verschraling van het normbewustzijn»; Rathenau Instituut: Opwaarderen. Borgen van publieke waarden in de digitale samenleving (2017), p. 62.

Alleen waar het gaat om partijen die de vrije beschikking hebben over hun rechtspositie en beide partijen ook instemmen, kan het overigens ook binnen die context.

Zie ook het pleidooi van Bart van Tongeren, algemeen deken van de Nederlandse Orde van Advocaten, onder de titel Algoritmes in de rechtsstaat (https://www.advocatenorde.nl/blog/algoritmes-in-de-rechtsstaat); en het eerder genoemde artikel van Van Ettekoven.

Prof. Mireille Hildebrandt: Democracy as action in the era of political behavioural targeting. Europe lecture 13 september 2018.

Zo onder meer: H.A. Reijers: Hybrid Science (oratie 2015); Henry Prakken: Komt de robotrechter er aan? NJB 2018, p. 269–274.

Kopieer de link naar uw clipboard

https://zoek.officielebekendmakingen.nl/kst-34775-VI-AH.html

De hier aangeboden pdf-bestanden van het Staatsblad, Staatscourant, Tractatenblad, provinciaal blad, gemeenteblad, waterschapsblad en blad gemeenschappelijke regeling vormen de formele bekendmakingen in de zin van de Bekendmakingswet en de Rijkswet goedkeuring en bekendmaking verdragen voor zover ze na 1 juli 2009 zijn uitgegeven. Voor pdf-publicaties van vóór deze datum geldt dat alleen de in papieren vorm uitgegeven bladen formele status hebben; de hier aangeboden elektronische versies daarvan worden bij wijze van service aangeboden.